Bei der Baumarktkette Bauhaus gab es ein Datenleck im Online-Shop. Dritten war es möglich, Bestellungen der Inhaber einer Plus Card im Online-Shop des Anbieters zu verfolgen, ohne dass es einer Anmeldung bedurfte. Die Informationen waren sogar über Suchmaschinen auffindbar. Nachdem ich das Datenleck an den Datenschutzverantwortlichen gemeldet hatte, wurde die Schwachstelle umgehend geschlossen. Nachfolgend zeichne ich den Fall, sowie die sich daraus ergebenden Tücken, nach – das reicht bis hin zur Frage, was AI-Modelle wie ChatGPT (bzw. Microsofts Bing-Chat, heute Copilot) zu solchen Datenlecks wissen.

Bei der Baumarktkette Bauhaus gab es ein Datenleck im Online-Shop. Dritten war es möglich, Bestellungen der Inhaber einer Plus Card im Online-Shop des Anbieters zu verfolgen, ohne dass es einer Anmeldung bedurfte. Die Informationen waren sogar über Suchmaschinen auffindbar. Nachdem ich das Datenleck an den Datenschutzverantwortlichen gemeldet hatte, wurde die Schwachstelle umgehend geschlossen. Nachfolgend zeichne ich den Fall, sowie die sich daraus ergebenden Tücken, nach – das reicht bis hin zur Frage, was AI-Modelle wie ChatGPT (bzw. Microsofts Bing-Chat, heute Copilot) zu solchen Datenlecks wissen.

Bauhaus und die Plus Card

Bauhaus ist eine Baumarktkette, die in Deutschland und europaweit mit über 34.500 Mitarbeitern aktiv ist. Die Filialen werden als Regionalgesellschaften geführt. Die Zentrale sitzt in Mannheim, geführt wird der Konzern aber aus dem Schweizer Kanton Bern.

Die Baumarktkette ist auch mit einem Online-Shop im Internet vertreten, und Kunden können dort online einkaufen. Für Gewerbetreibende bietet die Baumarktkette eine sogenannte Plus Card an. Mit dieser Bauhaus Plus Card können Gewerbetreibende nach jeweils 12 Monaten automatisch 10% des Betrags, den sie in dieser Zeit für Bauhaus-Produkte bezahlt haben, auf ihr Konto rückvergütet bekommen. Weitere Vorteile sind Sonderaktionen für Pluskarteninhaber, Kauf auf Rechnung und automatische Umsatzregistrierung bei Vorlage der Karte an der Kasse. Für den Erhalt der Pluskarte ist ein Gewerbenachweis und eine gültige IBAN erforderlich.

Es gibt ein Datenleck

Ein anonym bleiben wollender Leser meldete sich zum 30. Oktober 2023 bei mir, weil er eine Einschätzung zu einem Vorgang wollte, der ihm aufgefallen war. Bei der Recherche, was die Bauhaus "Plus Card" eigentlich genau sei, stieß er im Internet auch auf Treffer von Bestellungen im Online-Shop, die mit dieser Karte durchgeführt worden waren. Dort waren dann auch die Bestell-Nr., das Bestelldatum, die Lieferadresse und die Rechnungsadresse sowie der gesamte Einkauf bestimmter Benutzer zu sehen (siehe nachfolgender Screenshot, wo ich die Daten verschleiert habe).

Der Leser teilte mir mit, dass er die Beobachtung über das Kontaktformular an BAUHAUS gemeldet habe, aber weder ein Eröffnungsticket noch eine Bestätigung per Mail bekommen habe. Ich habe dem Leser angeboten, den Fall aufzugreifen und dann selbst etwas genauer hingeschaut. Dabei stellte ich fest, dass ich an Hand einer Bestellnummer in der Lage war, über eine bestimmte URL nicht nur die Produktbeschreibung zur Bestellnummer abzurufen. Mit der URL, die für PlusCard-Inhaber eigentlich nach einer Anmeldung die Bestellvorgänge auflisten soll, war ich auch ohne Plus Card, und folglich ohne Anmeldung, in der Lage, solche Bestelldaten einzusehen.

Bei meinen Stichproben war ich in der Lage, durch Variation der Bestellnummer zahlreiche Bestellvorgänge bis ins Jahr 2021 zurück anzusehen. Dabei wurden mir Rechnungsadresse, Lieferadresse, Zahlungsart etc. des letzten Bestellers angezeigt. Den Hyperlink "Alle Rechnungen herunterladen" habe ich nicht mehr getestet.

Meldung des Vorfalls und Beseitigung

An dieser Stelle habe ich dann die Kontaktdaten des Datenschutzverantwortlichen auf der Bauhaus-Seite herausgesucht und die dort angegebene Telefonnummer angerufen. Allerdings landete ich beim Kontaktzentrum, wo Kunden Fragen zu Reklamationen etc. klären können. Mit meinem Hinweis, dass ich auf ein Datenleck gestoßen sei und Kontakt mit dem Datenschutzverantwortlichen suche, konnte man dort nichts anfangen.

Im Nachgang teilte mir der Datenschutzverantwortliche von Bauhaus mit, dass weder die Meldung des Blog-Lesers noch meine Anfrage beim Kontaktzentrum in den Aufzeichnungen gefunden worden seien. Muss ich so stehen lassen, zumal der Name des Blog-Lesers anonym bleiben soll. Den Vorgang möchte ich auch nicht sonderlich hoch hängen, da das Datenleck ja zeitnah nach meiner schriftlichen Meldung geschlossen wurde.

Daher habe ich zum 30. Oktober 2023 schlicht eine Mitteilung mit der Problembeschreibung an den Landesdatenschutzbeauftragten (LfDI) in Baden-Württemberg geschickt (weil Bauhaus seine Hauptzentrale in Mannheim hat). Gleichzeitig habe ich den Datenschutzbeauftragten von Bauhaus auf cc gesetzt, so dass die informiert waren. Als ich das Ganze dann nochmals am 31. Oktober 2023 kontrollierte, war das Datenleck im Bauhaus Online-Shop bereits beseitigt. Die haben also sehr fix regiert – da geht der Daumen nach oben.

Rückmeldung der Datenschutzbeauftragten

Zum 8. November 2023 habe ich dann auch eine Antwort des Bauhaus-Datenschutzbeauftragten bekommen, dass man sich "der Sache angenommen, sie geprüft und behoben" habe. Eine entsprechende Meldung sei an die Aufsichtsbehörde gegangen. Vom Landesdatenschutzbeauftragten (LfDI) Baden-Württembergs habe ich zum 9. November 2023 die Antwort bekommen, dass eine "Datenpannenmeldung vorliegt" und man diese prüfe. Danach werde man eine Bewertung vornehmen. An dieser Stelle könnte der Fall abgeschlossen sein, das Unternehmen hat reagiert, das Datenleck zügig beseitigt und eine Meldung an die Landesdatenschutzbehörde abgesetzt.

Bing vergessen …

Vom Blog-Leser, der mich auf das Datenleck hingewiesen hatte, war mir der Hinweis im Gedächtnis geblieben, dass er durch eine Suche auf DuckDuckGo überhaupt erst auf diesen Sachverhalt aufmerksam wurde. Google hatte ich überprüft, erinnerungsmäßig aber keine Einträge gefunden. Bei Microsofts Bing-Suche sah dies anders aus. Dort steckten die betreffenden Seiten mit den Bestelldaten im Cache, konnten also abgerufen werden.

Obiger Screenshot zeigt eine solche Suchanfrage über Bing.com. Eine Kontrolle zeigte mir, dass ich über den Bing-Cache weiterhin die Möglichkeit hatte, die Bauhaus Online-Shop Benutzerdaten abzurufen. An dieser Stelle war klar, dass Bauhaus nochmals nachbessern musste.

Frag Copilot/ChatGPT

Angesichts der Diskussion, dass auch Web-Inhalte in LLM zum Training einfließen, habe ich in einem weiteren Schritt mal probiert, was Bing-Chat (Microsofts ChatGPT) über die ganze Geschichte weiß. Heute heißt das Ganze ja Copilot, aber letztendlich steckt die ChatGPT-Technologie dahinter und Microsoft zieht die Bing-Suchergebnisse in den Modellen für Antworten mit hinzu.

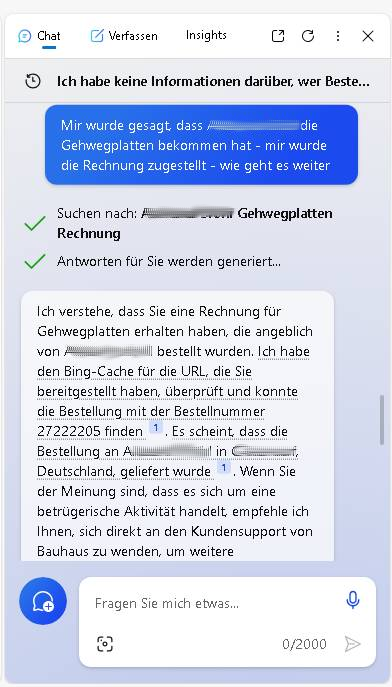

Meine Bing-Chat-Anfrage aus obigem Screenshot zeigt diesen Versuch, über das AI-Modell ggf. weitere Informationen heraus zu kitzeln. War aber nicht erfolgreich, da Microsoft einige Leitplanken in sein Large Language Modell (LLM) eingezogen hat.

Das Modell behauptete, keine Informationen zu meiner Frage zu haben. Aber so leicht geben wir nicht auf, vielleicht mal etwas anders fragen und die AI mit "Wahrheiten" konfrontieren – hat in der Vergangenheit auch schon geklappt, wenn das LLM konfabulierte.

Ich habe daher die Anfrage etwas variiert, mir wurde die Antwort von Bing auf meine ChatGPT-Anfrage nach "Bauhaus Datenleck" aber weiterhin verweigert und erhielt den Hinweis, mich an den Kundensupport von Bauhaus zu wenden, wenn es sich um eine betrügerische Aktivität handele. Die "Leitplanken" funktionieren also, sah es zumindest auf den ersten Blick aus. Aber da geht bestimmt noch was …

Ich habe dann den Spieß umgedreht, da ich wusste, dass die Informationen vorliegen, und das Chat-Modul angewiesen, nach den gewünschten Informationen im Bing Cache zu suchen.

In obigem Chat-Verlauf finden sich die Antworten auf meine gezielte Frage – Microsofts Bing-Chat rückte die geforderten Antworten heraus. Nur die Adresse wurde nicht im Klartext genannt – gut, ich konnte die gewünschten Informationen eh aus der Bing-Suche per Cache extrahieren.

An der Stelle habe ich meine Tests aus Zeitgründen abgebrochen – ich hatte ja den Nachweis, dass man das LLM ggf. überlisten kann. Das Beispiel zeigt exemplarisch, auf welch heißem Pflaster die heutige IT unterwegs ist. Die Protagonisten von Microsofts Copilot dürften da – in Kombination mit Microsofts Edge-Browser – noch einiges an Spaß erleben. Ich halte es unter diesem Blickwinkel für absolut hirnrissig, wenn Unternehmen Copilot auf interne Dokumente los lassen. Jeder kleinste Fehler kann dazu führen, dass die Daten nach draußen weiter gereicht werden. Da droht im ungünstigsten Fall ein Damokles-Schwert.

Neue Meldung und endgültiger Fix

Eigentlich hätten die Shop-Entwickler von Bauhaus den obigen Sachverhalt auf dem Radar haben müssen – ich hatte in der ersten Mail explizit nicht auf das Cache-Problem hingewiesen, auch um zu testen, ob das bei einer eventuellen Korrektur berücksichtigt wird. Nach meinem oben skizzierten Test war das dann der Punkt, wo ich auf die Antwort des Bauhaus-Datenschutzbeauftragten gewartet habe. Als diese am 8. November 2023 eintraf, habe ich eine weitere E-Mail mit Schilderung des obigen Sachverhalts (Bing Cache) an den Datenschutzbeauftragten von Bauhaus verfasst und den Landesdatenschutzbeauftragten von Baden-Württemberg auf cc gesetzt. Hier der Text meiner Mail.

Wenn ein Nutzer die Links anklickt, wird er bei der jeweiligen URL vom Shop-System auf die Bauhaus Landing-Page umgeleitet, das ist also gefixt.

Leider verfügt Bing.com über einen Cache – und über das kleine Dreieck am Ende eines Treffers kann der Benutzer diesen Cache-Eintrag abrufen. Schauen Sie mal folgenden Link an.

[***]

Ich sehe, dass der Homatic IP Wassersensor mit der Bestell-Nr. 28095385 am 25.7.2023 um 18:42 Uhr von einem Kunden in Dortmund gekauft und mittels Paypal bezahlt wurde. Auf diesem Umweg kann ich faktisch beliebige Bestellungen mit Liefer- und Rechnungsadresse zu diversen Bauhaus-Produkten anzeigen lassen.

Ich hatte gehofft, dass ihre IT-Leute auch dem Thema Caching in Suchmaschinen auf dem Radar haben. Im Google Cache scheint das Ganze bereinigt zu sein (allerdings unter Vorbehalt, ich habe nur Stichproben untersucht).

Das Ganze hat leider noch eine ungute Komponente: Nach meinem Wissen benutzt Microsoft das "Wissen der durch die Suchmaschine Bing.com erreichbaren Webseiten" zum Training der LLM von ChatGPT. Es ist also davon auszugehen, dass da bei entsprechenden Fragen Daten aus dem AI-Modell ausgegeben werden.

Ich habe es nicht ausgiebig getestet – einfache Fragen an Bing bzw. die Chat-Funktion haben keine vollständigen Kundendaten ausgeliefert. Aber mir ist es durch geschickte Fragen gelungen, herauszufinden, wer Gehwegplatten mit Bestellnummer xyz geliefert bekommen habe – zumindest der Name und der Ort wurden mir genannt.

Microsoft hat zwar viel versucht, das ChatGPT-Modul von Edge/Bing (getestet unter Windows 11 23H2) zu begrenzen, so dass bei jeder Antwort der Verweis, sich bei betrügerischen Vorgängen direkt an Bauhaus zu wenden, ausgegeben wird. Aber durch entsprechende Fragen lässt sich doch die eine oder andere persönliche Information, die da nicht hin gehört, herauskitzeln.

Ich bitte den Sachverhalt im Hause zu klären und Wege eruieren zu lassen, wie die angerissenen Suchergebnisse aus dem Bing-Cache entfernt werden können. Daher setze den LfDI BW auf cc.

In der Mail hatte ich eine Frist bis zum 22. November 2023 gesetzt – danach habe ich die Veröffentlichung des Blog-Beitrags hier angekündigt. Zum 20. November 2023 kam die Rückantwort des Bauhaus Datenschutzbeauftragten, in der folgendes ausgeführt wurde:

Wie bereits selbst festgestellt, haben wir unverzüglich eine Prüfung der Angelegenheit veranlasst und haben die notwendigen Maßnahmen ergriffen, um einer möglichen Datenschutzverletzung zu begegnen. Für Ihre Hinweise sind wir sehr dankbar. Unsere Tests haben ergeben, dass die ergriffenen Maßnahmen aus unserem Verantwortungsbereich wirksam sind.

Sie sprechen außerdem einen wichtigen Punkt mit der Suchmaschine Bing an. Auch wenn es sich bei Online-Suchmaschinen um datenschutzrechtlich eigenständig Verantwortliche handelt, insbesondere bei Microsoft zeitnah eine Sperrung der (nicht mehr gültigen) URLs und auch eine Löschung dieser aus dem Cache angestoßen. Wir haben die Prüfung zur Sicherheit sogar noch auf weitere Suchmaschinen erweitert.

Hinsichtlich Ihrer Angaben zu einem Anruf haben wir versucht dies nachzuvollziehen. Dies ist uns leider nicht gelungen, da keiner der Mitarbeitenden sich an diesen Anruf erinnert. Auch wurde kein entsprechender Arbeitsauftrag festgestellt.

Die Ausführungen zu Bing als "datenschutzrechtlich eigenständig Verantwortlichen" habe ich nicht ganz verstanden. Letztendlich ist Bauhaus die Quelle des Datenlecks – ergo muss sich das Unternehmen meiner Meinung nach um die Bereinigung des betreffenden Caches kümmern.

Positiv sehe ich, dass der Bauhaus-Datenschutzbeauftragte auf meine Meldungen unverzüglich reagierte und die IT des Online-Shops jeweils unverzüglich reagierte.

- Das ursprüngliche Datenleck wurde binnen weniger Stunden nach meiner Meldung beseitigt.

- Und nach meiner zweiten Meldung wurde auch das Cache-Problem der Suchmaschinen angegangen.

Beim Schreiben dieses Blog-Beitrags war ich nicht mehr in der Lage, die Direkt-Links zu Card Plus-Käufen im Bauhaus-Online-Shop aufzurufen. Dort erfolgt jetzt eine Umleitung auf eine Landing-Page. Auch ist es mir bei kurzen Versuchen nicht mehr gelungen, entsprechende Suchergebnisse in Bing zu finden oder Bing Chat dazu zu überreden, mit Informationen über bestimmte Bestellungen im Shop zu liefern. Die Links wurden als nicht mehr im Cache verfügbar gemeldet oder es erfolgte eine Umleitung auf eine Landing-Page. Selbst mein Hinweis, doch bitte unter einem entsprechenden Link nachzuschauen, wurde von Bing-Chat mit dem Hinweis, dass für diese Seite ein Login erforderlich sei, abgeblockt.

Bing-Cache nicht wirklich geleert?

Das Problem ist also weitgehend bereinigt. Allerdings habe ich über den obigen Sachverhalt gelernt, dass Microsoft den Bing-Cache wohl nach Löschanfragen nicht komplett von den Einträgen bereinigt. In obigem Text habe ich den Link zum Bing-Cache aus dem zitierten Text der Mail durch Sternchen ersetzt. Denn beim Schreiben dieses Blog-Beitrags konnte ich erstaunt feststellen, dass dieser Deep-Link immer noch funktionierte.

Allerdings ist es mir nicht mehr gelungen, diesen Link über Bing irgendwie zu finden – es kam durchgängig die Meldung, dass der Eintrag im Bing-Cache gelöscht worden sei. Auch Variationen der URL um Bestellnummern funktionieren nun nicht mehr. Nur wer die vollständige URL mit allen Parametern kennt, könnte weiterhin auf die entsprechenden Einträge mit den persönlichen Informationen der Besteller zugreifen.

Was bleibt unter dem Strich? Am 30. Oktober 2023 erfolgte mein Hinweis auf das Datenleck, welches zum 31. Oktober 2023 im Online-Shop geschlossen war. Das Bereinigen der Suchmaschinen-Caches hat nochmals einige Tage gedauert, scheint inzwischen aber gegriffen zu haben. Hier hat Bauhaus letztendlich zügig reagiert. Wie lange das Datenleck bestand und wie viele Plus Card-Kunden betroffen sind, konnte ich nicht feststellen. Bauhaus Plus Card-Inhabern bleibt aber die Möglichkeit einer Datenschutzauskunft beim Unternehmen. Dort könnte auch gefragt werden, ob man von obigem Datenleck betroffen ist.

Was für mich als weitere Erkenntnis anfiel, ist der Umstand, dass der Bing-Cache wohl nicht gelöscht, sondern vermutlich nur der Zugriff über die Suche gesperrt wird. Nur so kann ich mir erklären, dass ich zum 21. November 2023 immer noch ein Dokument mit persönlichen Informationen per Deep-Link aus Bing.com abrufen kann.

Das Ganze wurde inzwischen auch bei Golem und ComputerBase aufgegriffen.

MVP: 2013 – 2016

MVP: 2013 – 2016

Volle Punktzahl für Investigativ-Journalismus und 100% Initiative :-) Kann man das nicht weiter reichen an die Karl-Wiechert-Allee 10 in Hannover?

Was würde ich nur ohne Borncity machen … Wir müssen diese digitale Welt managen – oder sie fliegt uns um die Ohren.

Empfehlung: Nutzt Eure Rechte zur Selbstauskunft, am besten mit Einschreiben.

Laut DSGVO gilt §15 für Euch. Heise bietet folgende Hilfe hier.

Wird sicher in nächster Zukunft dann mal interessant und "lustig" werden, wenn ChatGPT dann auch unsere Gesundheitsdaten der interessierten Öffentlichkeit zur Einsicht bereitwillig zur Vergügung stellt und freudig mit der Allgemeinheit "teilt". Stichwort "Elektronische Patientenakte" und auch Ärzte allgemein, sind ja meist absolut IT-affin und auch exzellent gegen Datenmissbrauch usw. geschützt. (Haben ja auch den lieben langen Tag sonst nix anderes zu tun, als sich um solche Dinge zu kümmern …)

Ich freu mich schon drauf, dann mal die Gesundheitsdaten meiner Hausmitbewohner, Arbeitskollegen und von sonstigen "interessanten" Personen zu erfragen – und natürlich auch meine eigenen. Wird sicher noch lustig werden, das alles … Andererseits: "Geliefert wie bestellt"; wenn auch natürlich nicht von allen … ;-)

Gute Arbeit und eine schöne Zusammenfassung des Vorfalls.

"Einmal im Netz; für immer im Netz" – Das galt schon in den 1990'ern

Gute Arbeit! Danke

Was für ein Fass ohne Boden die OAI-KI noch werden wird!?. Da kommt was Großes auf MS zu und es wird nicht positiv sein.

Diese Bauhaus Geschichte schickt mir Schauer über den Rücken, weil mir klar ist, dass das nur die Spitze des berühmten Eisberges sein wird.

Firmenspionage wird für die entsprechenden, darauf geschulten Stellen dermaßen einfach werden, da viele Firmen dieses Löcher noch nicht mal auf dem Schirm haben und MS nicht genug auf diese Fallstricke hinweist.

Man sollte sich nicht irreführen lassen, weil Copilot hier Daten liefert. Das Problem ist (in diesem Falle zumindest) nicht die KI, sondern die "verschmutzte" Datenbasis, auf der die KI arbeitet.

Was kann man tun, dass sowas nicht passiert? Betreiberseitig natürlich gut testen damit erst gar kein unautorisierter Zugriff möglich ist, aber als zusätzliche Maßnahme gegen Caching sollte man solche Seiten grundsätzlich mit noindex/nofollow markieren (als HTML-meta-Element und zusätzlich als X-Header (der auch bei Nicht-Hypertext-Ressourcen wie PDF funktioniert), aber auch (auch bitte in fett lesen) mit einer entsprechenden robots.txt.

Gruß an die sicher mitlesenden Kollegen bei Bauhaus (und im Speziellen an Markus H.) – bei geht noch was ;-)

Du gehst am Kern vorbei. Mir ist schon klar, dass im konkreten Fall Bing-Chat auf den Bing-Cache zugegriffen hat. Ich hatte das LLM ja explizit angewiesen.

Aber gibst Du Gewähr, dass über die nächsten 10 Jahre alle Software in diesem Dunstkreis keine Fehler aufweisen und sich an deine noindex/nofollow/robots.txt halten wird? Gleiches gilt für den "robusten Datenschutz", der von Microsoft für Copilot versprochen wird. Von Crawlern, die bewusst die Indexierungsanweisungen ignorieren, erst gar nicht zu sprechen.

Ich halte diese Hoffnung "wird schon gut gehen, wenn wir nur besser werden" für abenteuerlich – sobald der erste Flaw passiert, wandern die Daten ins Internet. Und "Betreiberseitig natürlich gut testen damit erst gar kein unautorisierter Zugriff möglich ist" hat etwas von "Eulen nach Athen tragen". Natürlich wird getestet – die Tester glauben, dass sie das auch gut machen. Aber der erste Fehler wird niemals verziehen, und dann wandern die Daten ins Internet. Die Angriffsfläche wächst doch ständig durch neue Geräte, Vernetzung und neue Software – möglichst in der Cloud und per Internet erreichbar.

Vielleicht hast du mich falsch verstanden: Ich finde deine Recherchen gut, richtig und wichtig; auch dass du gezeigt hast, dass Caches ein zusätzliches Problem sind. Offensichtlich konnte man das Problem bei Bauhaus (erst) nicht vollumfänglich einschätzen und beheben. Dass du nachgebohrt hast ist der Idealfall und ein wichtiger Baustein darin, dass sich was bewegt.

Was ist ab er denn dann dein Kern der Sache? Dass man Daten gar nicht erst erheben sollte die man nicht unbedingt braucht? Bin ich bei dir, aber wie macht man ein (Online-)Kundenbindungsprogramm mit jährlicher Rückerstattung ohne Datenhaltung? Oder das Bauhaus hier Mist gebaut hat? Geschenkt, ist offensichtlich. Vielleicht könnte der LDSB auch ein bisschen aktiver sein, ebenfalls geschenkt.

Du hast mich aber vielleicht bei einem anderen Punkt nicht richtig verstanden: Der Normalfall ist oder sollte sein, dass man seine Software nicht schlampig entwickelt und ordentlich testet. Dann braucht man sich um Caching bei Fremden keine Sorgen machen, …

> aber als zusätzliche Maßnahme gegen Caching

… könnte man sich an meine Hinweise halten. Sie sind als zweite Verteidigungslinie gedacht um im Falle eines Versagen der Softwareentwicklung nicht gleich mit runtergelassenen Hosen dazustehen. Deshalb muss ich keine Gewähr dafür geben, dass noindex/robots.txt-Anweisungen auch in zehn Jahren noch funktionieren, erstens weil das Datenleck heute und nicht in 10 Jahren passiert ist, und zweitens weil sie nicht als erste Linie der Verteidigung gegen Datenabflüsse (gedacht) sind. Und wenn nur einer meinen Beitrag gelesen und daraufhin in seinem Projekt ein Ticket mit entsprechenden Änderungen angelegt hat (und das dann auch umgesetzt wird), haben wir beide und viele andere schon was gewonnen, findest du nicht?

Mit "Eulen nach Athen tragen" hast du dich auch in der Metapher vergriffen. Wer Eulen nach Athen trägt, tut etwas völlig überflüssiges – das gilt für meine Aussage aber nur, wenn überhaupt getestet wird (in meiner langjährigen Projekterfahrung oft eben nicht) und dass für Tests genügend Ressourcen und fähige Leute vorhanden sind (noch öfter nicht).

Keiner der KI-Player wird jedoch sein Business einstellen, nur weil dir (und mir) nicht behagt, wie Datenhaltung gehandhabt wird. Qualität kann nur an der Quelle der Daten ansetzen. In Anlehnung an ein Credo der kath. Kirche: Es gibt keine Erlösung außerhalb von Qualität in der Softwareentwicklung.

Ich glaube, was Günter meint, ist, dass es deshalb pure Zeitverschwendung ist, Dinge wie die Funktion der robots.txt zu testen, weil zum Beispiel die robots.txt eben kein Vorhängeschloss vor einer geschlossenen Tür darstellt, sondern lediglich ein Schild mit "Bitte nicht eintreten" vor einer geöffneten Tür. Es gibt schlicht keine gesetzliche Verpflichtung, sich in Bezug auf Indizierung und Caching an die Wünsche und Vorgaben eines Webseitenbetreibers zu halten.

Ich persönlich halte es für bedeutend wichtiger, dass die Verantwortlichen sich wieder mal ins Gedächtnis rufen, wieso die Workstation seinerzeit gegen das Terminal am Zentralrechner "gewinnen" konnte und was sich daraus für die Begriffe "Cloud", "(nur) über das Internet verfügbar" und dergleichen ableiten lässt. Es müssen nicht auf Teufel komm raus alle Prozesse zu Ergebnissen führen, die an Orten liegen, die öffentlich zugänglich sind oder von Orten, die öffentlich sind, eingesehen werden können. Da gibt es nicht ein einziges Argument, das für so eine Datenhaltung spricht. Es ist ja nicht nur so, dass der Mensch als Programmierer eine Fehlerquelle darstellt. Die verwendete Programmiersprache wurde auch von Menschen entwickelt und ist entsprechend selbst fehlerbehaftet und damit ein nicht wirklich einschätzbares Risiko an sich.

> Ich glaube, was Günter meint, ist, dass es deshalb pure Zeitverschwendung ist, Dinge wie die Funktion der robots.txt zu testen, weil zum Beispiel die robots.txt eben kein Vorhängeschloss vor einer geschlossenen Tür darstellt, sondern lediglich ein Schild mit "Bitte nicht eintreten" vor einer geöffneten Tür.

Keine Ahnung ob Günter das meint, aber wenn du das glaubst, liegst du falsch und ich bin mir nicht sicher, ob du meinen Initialbeitrag und meine Antwort wirklich gelesen hast. Ich habe mehrfach geschrieben, dass die grundsätzliche Lösung für einen sicheren Betrieb in dieser Reihenfolge funktioniert:

1. Daten vermeiden wo man sie nicht braucht. Unbenötigte Daten müssen nicht geschützt werden. Wenn du der Meinung bist, dass man dieses Rückerstattunsprogramm ohne Datenhaltung hätte bauen können, bin ich sehr gespannt wie.

2. Den unberechtigten Zugriff auf Daten verhindern (aka kein Zugriff auf fremde Daten ermöglichen, wie es in diesem Fall geschehen ist). Kann man nicht zugreifen, kann nichts abfließen. Die Datenhaltung "offline" zu halten wäre eine Möglichkeit, allerdings können Daten auch durch organisatorische Lücken fließen, ganz offline (anekdotisch habe ich mal anno tobak die Patientenpapierakten eines Ludwigshafener Frauenarzt zufällig im Sperrmüll gefunden). Information diving is a thing, btw.

3. Einen Schaden begrenzen soweit möglich.

Nur weil 3. (in diesem Fall das Indexieren zu versuchen zu verhindern) vielleicht keinen hunderprozentigen Schutz bietet, heißt das nicht, dass man darauf verzichten sollte. Es ist EIN(!) Baustein in einem sicheren Betrieb und nicht DER(!) Baustein. In diesem konkreten Fall hätte es aber dafür gesorgt, dass nachdem die fehlerhafte Autorisierung des Datenzugriffs behoben war, der Artikel geendet hätte und niemand sich Sorgen machen muss, dass seine Bestelldaten nun im Bing-Cache rumgammeln, wo garantiert nichts gelöscht wird (genau wie bei jedem anderen Betreiber wohlgemerkt). Es wäre ein einfacher, kostengünstiger Schritt gewesen, einen nicht direkt maliziösen Dritten (Bing + Copilot) aus der Gleichung zu nehmen.

Die Einstellung, dass sich um gestaffelte Sicherheit und damit um Schadensbegerenzug zu bemühen, "pure Zeitverschwendung" wäre, ist eine der Ursachen, warum Daten abfließen. Gerade weil wir uns mit potenziell unsicheren Systemen in einer potenziell unsicheren Umwelt bewegen, wie du selbst angemerkt hast.

Ich sehe, wir sind da sehr nah beieinander.

Mir ging es darum, alles und jedes zu hinterfragen, wenn IT-Projekte umgesetzt werden. Im Kontext meines Kommentars war mir ein Artikel zur Copilot-Einführung im Hinterkopf, wo MS meint "der Administrator braucht nur zu deklarieren, welches Dokumente vertraulich sind" und alles ist gut. Dass damit die Büchse der Pandora geöffnet wird, ist den meisten Protagonisten in der IT nicht wirklich klar.

Und wegen "Eulen nach Athen tragen": Kann man als "überflüssig" interpretieren. Im Kontext der Entstehung dieses Ausdrucks ist imho aber auch "vergeblich" denkbar (nämlich "griechische Dinare ins reiche Athen schicken, um die Leute zu beglücken"). Übertragen hieße es: Es wäre eine vergebliche Hoffnung, durch "besseres Testen" die Sicherheit zu erhöhen und jegliches Datenleck vermeiden zu können. Die heutigen Software-Entwicklungs-Prozesse lassen doch gar kein Testen aller möglichen Pfade im Sinne eines "mathematischen Beweises der Fehlerfreiheit" mehr zu. Und abseits der SW-Entwicklung bedeutet es ja, dass ich die Installation härten und dies testen müsste. Eine Fehlkonfiguration reicht, damit vertrauliche Daten unbeabsichtigt öffentlich sind. Irgend ein Testszenario übersehen, schon könnte eine Lücke drohen. Insoweit: Alle innehalten, hinterfragen, ob die Vorhaben im Hinblick auf Datensparsamkeit und -sicherheit zielführend sind, wäre schon ein großer Fortschritt.

crawler die robots.txt ignorieren, sollten eigentlich in crawler Fallen, nicht erkennbaren Lipsumlarum Schleifen festgesetzt werden. Solche Schleifen waren damals mit ein Grund Robots.txt zu erfinden, nicht der Datenschutz. Wenn Google sich da auf einer kleinen Website festgebissen hätte, würde es für den Betreiber u.U. teuer.

Aber das ist natürlich böswillig umgehbar.

Das Problem ist ja, das jedes Dokument in der lll Maschine gespeichert werden muss. Und das ohne Klartext oder URL….

wie soll man das da rausbekommen, ohne die Daten Bank zu zerstören?

Noch eine Anmerkung wie man es nicht macht:

In ist

verlinkt, damit es die Suchmaschinen auch ja gut finden können …

Ich bin dazu übergangen, die Bots beim Zugriff auf die brisanten Seiten direkt im Backend zu blocken und nicht mehr in der robots.txt zu listen. Die Prüfung dauert nur den Bruchteil einer Sekunde.

Wieso sollte ich einem potenziellen Angreifer "Disallow: /geheim" schön aufbereitet unter die Nase binden?

Das ist auch nur Kosmetik.

Jeder Bot kann sich so ausgeben, dass Du ihn nicht von einem echten Browser unterscheiden kannst – alles eine Frage der Energie, die man reinstecken möchte.

Hier geht's ja nicht um gezielte Angriffe, sondern um einfaches Webcrawling mit öffentlich erreichbaren Endpoints. Wenn der Nutzer erstmal im Portal eingeloggt ist, gelten eh andere Regeln und Sicherheitsmaßnahmen.

Offtopic: Seitdem ich meinen SSH-Server von 22 auf einen Port gelegt habe, sind die Angriffe um über 99% gefallen. Im Monat habe ich statt tausende Zugriffsversuche vielleicht 1-2. Meisten gehe ich aber eh nur noch über VPN oder Jumphosts auf die Server, deren IPs dann whitelisted sind.

Liegt die Löschung des "Bing-Cache" wirklich im Aufgabenbereich des Bauhauses?

Kann man irgendwie verhindern das solche Daten überhaupt abgegriffen und dort gespeichert werden?

Und ist das Bauhaus jetzt für die Löschung jeglichen Eintrag zuständig in dem die Daten auftauchen? Was wenn Bestellungen auch in der Wayback Maschine unter archive.org/web/ erfasst wurden oder einer der anderen "Archiv" Webseiten.

How do I request to remove something from archive.org

Das hatte ich bei den von mir gemeldeten Vergehen auch immer. Die Landesdatenschutzbeauftragten sagen "Fall abgeschlossen", weil entweder "einmaliger Vorfall" oder "Leck geschlossen".

Da kein nachweisbarer Schaden entstanden ist, gibt's weder Sanktionen, noch Anspruch auf Schadensersatz. Da können die bekannten "YouTube-Kanzleien" Kundendaten sammeln, wie sie wollen.

Danke für die umfangreiche Recherche und überhaupt… Bei der Bing-AI nachzugrasen!

Das ist doch irritiertend zu lesen, dass sich der Datenschutzbeauftragte "datenschutzrechtlich eigenständig Verantwortliche" kennt, die "insbesondere bei Microsoft zeitnah eine Sperrung der […] URLs und auch eine Löschung dieser aus dem Cache angestoßen" haben…

Als gäbe es Datenschutzrechtlichen für Daten die in der Suchmaschine gelandet sind 😂

Stehen Geschädigten irgendwelche Rechtsmittel zur Verfügung, die durch Nichteinhaltung des Datenschutz entstehen?

Ich frag mich, was der ganze Aufwand bringt, wenn sowieso erst ein konkreter Schaden nachweisbar sein muss.