[English]Microsoft arbeitet im Hintergrund ja an Windows Server 2025, der neuen Server-Generation, der 2025 veröffentlicht werden soll. Mit an Bord auch Hyper-V als Virtualisierungsplattform. Die Tage hat Jeff Woolsey, Microsofts Principal Program Manager for Azure Stack HCI, Windows Server and Hybrid Cloud einige Daten veröffentlicht, was die Entwickler für Hyper-V auf dieser Plattform planen. Die Kurzfassung: Es dürfte einen massiven Leistungsbooster geben, wenn man halten kann, was man verspricht.

[English]Microsoft arbeitet im Hintergrund ja an Windows Server 2025, der neuen Server-Generation, der 2025 veröffentlicht werden soll. Mit an Bord auch Hyper-V als Virtualisierungsplattform. Die Tage hat Jeff Woolsey, Microsofts Principal Program Manager for Azure Stack HCI, Windows Server and Hybrid Cloud einige Daten veröffentlicht, was die Entwickler für Hyper-V auf dieser Plattform planen. Die Kurzfassung: Es dürfte einen massiven Leistungsbooster geben, wenn man halten kann, was man verspricht.

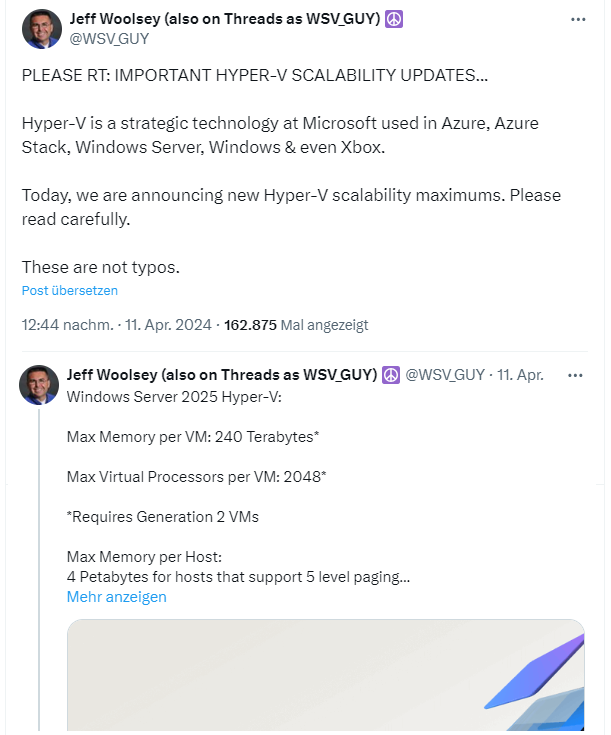

Auf der Plattform X schreibt Jeff Woolsey, dass er ein wichtiges Update bezüglich Hyper-V und dessen Skalierbarkeit habe und erwähnt erneut, dass Hyper-V strategisch für Microsoft sei. Dann kündigt er die neuen Maximal-Werte bei der Virtualisierung an, die Hyper-V unter Windows Server 2025 unterstützen soll.

Die Zahlen sind beeindruckend und Woolsey weist darauf hin, dass es keine Tippfehler seien. Pro virtuelle Maschine sollen 240 Terabyte an (RAM-)Speicher unterstützt werden, und pro VM sind bis zu virtuelle 2048 Prozessoren möglich (Windows Server 2022 ermöglicht nur 1024 virtuelle Prozessoren pro VM). Die 4 Petabyte Speicher gelten für Hosts, die Paging auf 5 Ebenen unterstützen, 256 Terabyte gelten für Hosts, die Paging auf 4 Ebenen unterstützen.

Microsoft hat dazu den Beitrag Plan for Hyper-V scalability in Windows Server vom 10. April 2024 publiziert, der noch einige weitere Details der zukünftigen Pläne verrät. So sollen vier Virtual Fibre Channel-Adapter – für verschiedene virtuelle SAN unterstützt werden. Die Kapazität einer virtuellen Disk beträgt 64 TB für das VHDX-Format und 2.040 GB für das VHD-Format.

The Register hatte vor einigen Tagen in diesem Artikel bereits auf die Pläne Microsofts hingewiesen. Ich kann es nicht wirklich beurteilen, aber von den Leistungsdaten liest es sich für mich "gigantisch". Meinem Eindruck nach zielt Microsoft damit auf große Hoster oder Rechenzentren, in denen VMware vertreten war. Wird auch von heise so gesehen, die sich in diesem Artikel über das Thema auslassen.

MVP: 2013 – 2016

MVP: 2013 – 2016

Mal eine ganz ernsthafte Frage nutzt man, wenn man solche eine Hardware hat nicht etwas anderes als Microsoft Windows und Hyper-V?

Kommt wohl auf den Einsatzzweck an. Wir hatten letztes Jahr einen internen Test zwischen VMWare ESXi 8 und Citrix Hypervisor 8.2 auf der selben Hardware. Da ein älteres System mit Microsoft Hyper-V 2019 (DataCenter) vorhanden war, wurde auch dort getestet.

Interessanterweise kam bei CPU-Leistung trotz älter Hardware mehr in den VM an, als bei aktueller Hardware und den beiden anderen Systemen. Zwar war ESXi in der Toleranzgrenze, hatte aber etwas modernere Hardware.

Hyper-V ist nicht schlecht. Bei GPU gibt es (noch) Nachteile. Daher finde ich GPU Partitionierung bei 2025 sehr spannend. Zwar kann man seit Windows Server 2019 dediziert Hardware in die VM durchreichen, aber dann halt nur pro Hardware eine VM und die VM kann logischerweise keine Live-Migration mehr nutzen.

Hi,

das wusste ich jetzt noch gar nicht, mir war nur bekannt, dass eine ältere Variante für Grafik mal aus Sicherheitsgründen entfernt wurde.

Bei nem privatem Projekt wäre ne serielle Schnittstelle in die VM mal interessant, da hab ich wieder was zum rumprobieren ;-)

Danke für die Info.

Serielle Schnittstellen kann man schon seit Ewigkeiten in eine Hyper-V VM durchreichen.

Was nicht geht ist das Durchreichen von LPT und USB.

Um LPT ist es nicht schlimm, die Schnittstelle ist tot, aber es wäre wünschenswert, wenn man wenigstens USB durchreichen könnte.

Die Aussage ist so nicht ganz korrekt. USB kann man aktuell auch schon in eine VM durchreichen. Das nennt sich USB-Passthrough-Zugriff mittels SCSI-Controller. Hier ist jedoch zu beachten, dass man hier nur Zugriff auf eine Daten Partition erhalten kann. USB Dongles wie von Datev usw. funktionieren so nicht. Auch sollte man sich dann Gedanken bzgl. einer möglichen Live-Migration machen.

Ich habe mal die Zahlen verglichen.

– 240 TB RAM bei Gen 2 VMs kann schon Server 2022, also nichts neues bei Server 2025.

– Die Anzahl der vCPUs wird von 1024 auf 2048 verdoppelt.

2048 vCPUs gehen aber nur, wenn man genau 1 VM betreibt, denn der Host begrenzt das auch auf 2048 vCPUs für alle VMs zusammengenommen.

Hat man z.B. auf dem Server 1024 VMs laufen, so hat man also im Durchschnitt nur 2 vCPUs pro VM.

Und wenn man das berücksichtigt, dann sind die 2048 vCPUs gar nicht mehr so üppig.

Wenn jede VM 16 vCPUs hat, dann kann man max. 128 VMs betreiben.

Der Rest entspricht Server 2022.

Beim Host auch alles gleich bis auf die Anzahl der CPUs: 2048 anstatt 1048.

Zum Vergleich Server 2016 und 2019:

RAM pro VM max. 12 TB, max. vCPUs: 240 bzw. 250, RAM auf dem Host: 24 TB.

So richtig revolutionär ist das, was Hyper-V 2025 gegenüber 2022 bietet, nicht.

Den wirklichen Vorteil bei Server 2025 gegenüber Server 2022 sehe ich eigentlich nicht in der Zahl der vCPUs, sondern in der versprochenen höhere Geschwindigkeit.

vCPUs sind nicht exklusiv einer VM zugewiesen, du kannst also auch gerne bei allen 128VMs jeweils 128vCPUs haben, darf halt nur nicht das Maximum des Hosts überschreiten. vCPUs sind Threads des vmwp-Prozesses und nicht mal an eine physische CPU gebunden.

@topic. Mir wäre ein verbesserter Codec für RemoteFX mal lieber (AV1 oder zumindest mal H.265) als theoretische Maximallimits für Hyperv die die meisten User wohl nie benötigen werden.

Das ist schon klar.

Und vCPUs haben auch nichts mit der Anzahl der Cores der CPUs des Hosts zu tun, wie es jemand im Heise-Forum vermutet.

Auf unserer AMD Epyc 7001 CPU gabs erstmal nen massiven Performancedrop in den VMs, als wir von Windows Server 2012 Hyper-V auf Windows Server 2019 Hyper-V umgestiegen sind. Schuld war letztendlich der neue 'Core'-Schedulermode – umgestellt auf den 'Classic'-Mode und schon lief das wie früher. Achso, und das automatische Hochtakten von einer VM benutzter Kerne funktioniert auch mehr schlecht als recht -> Energiesparplan von Balanced auf Höchstleistung und man hat wieder vollen Boosttakt.

MS sollte mal ihren Core-Scheduler mit Windows Server 2025 nochmal gegen verschiedene CPU-Architekturen gegenchecken. Das waren locker 50% Performanceverlust bei uns, wenn das mal reicht.

Damit haben wir auch immer wieder herumgekämpft. Dabei war es egal ob Hyper-V, ESXi oder XenServer. Bei Virtualisierung gibt es immer wieder Probleme, die durchaus komplex ist.

Bei unseren letzten Optimierungen konnten wir Hyper-V immerhin bei Balanced lassen. Unter anderem XenServer muss zwingend bei Performance stehen. Wir haben hier aber Intel CPUs.

Für mich eher ein absolutes Unding Seitens Microsoft das die Standardenergieeinstellung vom Windows Server auf "Ausbalanciert" und nicht auf "Höchstleistung" steht. Ebenso dass im Gerätemanager beim jeweiligen Netzwerkadapter immer das Häkchen unter Enegergieverwaltung gesetzt ist, dass der Computer das Gerät ausschalten kann, um Energie zu sparen.

Kannst du mir erklären, wieso du den Haken beim Netzwerkadapter setzt? Lese ich immer wieder, aber niemand kann es mir begründen. Habe ich in meinen 20 Jahren IT noch nie gesetzt und hatte noch nie Probleme.

Den Haken setze ich nicht, der ist automatisch gesetzt. Nur wenn der Windows Server direkt auf Hyper-V läuft und den Hyper-V Netzwerkadapter hat, gibt es im Gerätemanager beim Netzwerkadapter die Option "Energieverwaltung" nicht.

Es gibt noch ein paar Sachen, die bei Server gegenüber dem jetzigen Standard geändert gehören.

Warum z.B. ist bei Server der Audiodienst und der Druckdienst standardmäßig aktiv?

Den Druckdienst braucht man eigentlich nur bei Druckservern und den Audiodienst eigentlich gar nicht.

Danke für den Tipp bzgl. AMD Systemen und dem Schedulermode. Wir haben hier seid letzter Woche auch ein AMD System mit erstaunlich schlechter Performance….

Hast du das einfach per CMD Befehl "bcdedit /set hypervisorschedulertype Classic" gelöst oder gibt es hier noch etwas zu beachten?

Ne, hab das genau so gemacht. Danach natürlich den Hyper-V Host neustarten und schon ging Single-Threat Leistung massiv nach oben. CPU ist ein Epyc 7401P @170W TDP und 8x8GB DDR4-2666 (Octachannel).

Ich hatte in einer einfachen Windows 10 VM mal CPUZ ST-Bench laufen lassen.

Core-Scheduler: ~170 Punkte

Classic-Scheduler: ~270 Punkte

Hyper-V Host: ~340 Punkte

Man merkt das auch in der VM, ist alles fluppiger. Vielleichts liegts auch an der Zen1 Architektur (da gabs ja noch keine Trennung zwischen IO-Die und Compute-Dies), die da besonders anfällig gegen ist.

Ich betreue noch Intel-Hyper-V Server (sind glaub aus der Cascade-Lake Zeit) und die laufen mit dem Core-Scheduler unauffällig.

Thx! Bei uns hat dies leider nichts gebracht. Ist aber auch ein Epyc 7282. Na dann muss ich weiter schauen :)

Für das deaktivieren von all dem kram kann man doch doch gut das VMwareOSOptimizationTool nutzen oder wird es nicht mehr gepflegt. Dann ne Vorlage erstellen und gut.