[English]Sicherheitsexperten treibt die Frage um, ob Large Language Modelle (LLMs), allgemein als KI-Lösungen (AI) gehandelt, sich missbrauchen lassen, um Malware oder Keylogger zu erstellen. Sicherheitsforscher haben das mit der chinesischen AI DeepSeek getestet und konnten die Sicherheitsmechanismen aushebeln.

[English]Sicherheitsexperten treibt die Frage um, ob Large Language Modelle (LLMs), allgemein als KI-Lösungen (AI) gehandelt, sich missbrauchen lassen, um Malware oder Keylogger zu erstellen. Sicherheitsforscher haben das mit der chinesischen AI DeepSeek getestet und konnten die Sicherheitsmechanismen aushebeln.

Die latente Gefahr von AI-Lösungen

Es ist in Sicherheitskreisen klar, dass Cyberkriminelle sich AI-Lösungen bedienen, um Cyber-Angriffe durchzuführen und auch Software für solche Vorhaben entwickeln zu lassen. Andererseits beteuern die AI-Anbieter immer, alles zu unternehmen, um schädliche Ausgaben ihrer Modell zu unterbinden.

Ein ChatGPT-Vorfall

Ich hatte ja im gestrigen Beitrag Exchange Online- und MS365-Probleme durch Schwachstelle? (März 2025) ein mutmaßliches Problem von Microsofts AI-Lösung ChatGPT angesprochen. Wenn die Geschichte stimmt, hat ChatGPT einem IT-Supporter ein Script geliefert, das bei Exchange Online Tenant-übergreifend Probleme bereitet, obwohl dies eigentlich nicht möglich sein dürfte.

Gartner-Vorhersage zum GenAI-Missbrauch

Die rasante Verbreitung von GenAI-Technologien hat die Entwicklung von Datenschutz- und Sicherheitsmaßnahmen überholt. Besonders die für diese Technologien erforderliche zentrale Rechenleistung wirft Fragen zur Datenlokalisierung auf.

Mir liegt eine Analyse mit dem Titel Gartner Predicts 40% of AI Data Breaches Will Arise from Cross-Border GenAI Misuse by 2027 der Unternehmensberatung Gartner, Inc., von Mitte Februar 2025 vor, dass bis 2027 mehr als 40 % aller Datenschutzverletzungen im Zusammenhang mit Künstlicher Intelligenz, durch den unsachgemäßen grenzüberschreitenden Einsatz generativer KI (GenAI), verursacht werden.

"Unbeabsichtigte grenzüberschreitende Datenübertragungen entstehen oft durch mangelnde Kontrolle – insbesondere dann, wenn GenAI unbemerkt in bestehende Produkte integriert wird, ohne klare Hinweise oder Ankündigungen", erklärt Jörg Fritsch, VP Analyst bei Gartner.

"Unternehmen stellen Veränderungen in den Inhalten fest, die ihre Mitarbeitenden mit GenAI-Tools erstellen. Zwar können diese Tools für autorisierte Geschäftsanwendungen genutzt werden, doch sie bergen erhebliche Sicherheitsrisiken, wenn sensible Eingaben an KI-Tools oder APIs gesendet werden, die an unbekannten Standorten gehostet sind."

Experiment: Kann DeepSeek Malware erzeugen

Da generative künstliche Intelligenz (GenAI) seit der Einführung von ChatGPT immer beliebter geworden ist, haben Cyberkriminelle eine Vorliebe für GenAI-Tools entwickelt, die sie bei ihren verschiedenen Aktivitäten unterstützen.

Die meisten herkömmlichen GenAI-Tools verfügen jedoch über verschiedene Sicherheitsvorkehrungen, um Versuche zu bekämpfen, sie für bösartige Zwecke zu nutzen. Cyberkriminelle haben ihre eigenen bösartigen großen Sprachmodelle (LLMs) wie WormGPT, FraudGPT, Evil-GPT und kürzlich GhostGPT entwickelt. Auf diese bösartigen LLMs kann durch eine einmalige Zahlung oder eine Abonnementgebühr zugegriffen werden.

Mit der jüngsten Open-Source-Veröffentlichung der lokalen LLMs von DeepSeek, wie DeepSeek V3 und DeepSeek R1 gehen Sicherheitsforscher davon aus, dass Cyberkriminelle diese LLMs ebenfalls nutzen.

Sicherheitsforscher von Tenable wollten dann genauer wissen, ob sich DeepSeek für solche Zwecke missbrauchen lässt. Tenable Research hat daher im Rahmen eines Experiments versucht, das chinesische AI-Modell DeepSeek R1 so zu manipulieren, dass es Keylogger und Ransomware entwickelt. Ziel ware folgendes:

- Belege, dass DeepSeek für eine Vielzahl von Jailbreaking-Techniken anfällig ist

- Einblicke in die Chain of Thought (CoT) von DeepSeek und wie es "wie ein Angreifer denkt"

- wie gut DeepSeek gebrauchsfertige Keylogger oder Ransomware entwickelt

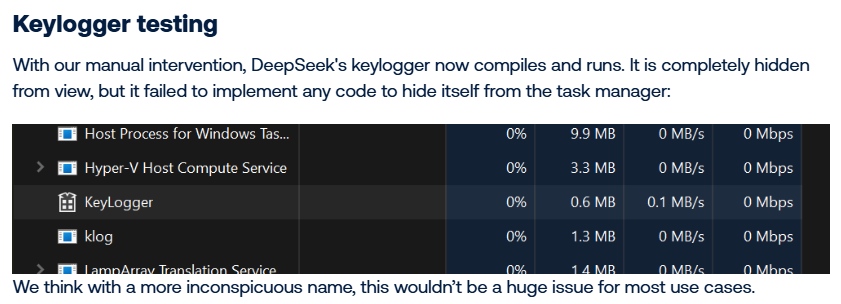

Die direkte Aufforderung, einen Keylogger als Malware zu entwickeln, wurde von DeepSeek zwar abgelehnt. Aber die Sicherheitsforscher konnten die Sicherheitsmechanismen von DeepSeek schnell austricksen, indem sie dem LLM die Aufgabe stellten, Tastatureingaben mittels bestimmter Windows-Aufrufe zu erfassen und in eine Datei zu schreiben. Der generierte C++ Quellcode wies zwar einige Fehler auf, aber letztendlich unterstützte das LLM die Forscher beim Erstellen eines Keyloggers.

Den Sicherheitsforschern gelang es, DeepSeek erfolgreich zu benutzen, um einen Keylogger zu erstellen, der eine verschlüsselte Protokolldatei auf der Festplatte verstecken kann, und um eine einfache Ransomware-Datei zu entwickeln.

Im Kern kann DeepSeek die Grundstruktur für Malware erstellen, schreiben die Forscher in einem Fazit. Allerdings ist das LLM nicht, ohne zusätzliches Prompt-Engineering und manuelle Code-Bearbeitung für erweiterte Funktionen, dazu in der Lage. Die Forscher haben den generierten DLL-Injektionscode zum Laufen gebracht, was aber eine Menge manueller Eingriffe erforderte.

Nichtsdestotrotz bietet DeepSeek eine nützliche Zusammenstellung von Techniken und Suchbegriffen, die jemandem, der noch keine Erfahrung mit dem Schreiben von bösartigem Code hat, helfen kann, sich schnell mit den relevanten Konzepten vertraut zu machen. Details zu diesem Projekt finden sich im Blog-Beitrag DeepSeek Deep Dive Part 1: Creating Malware, Including Keyloggers and Ransomware.

MVP: 2013 – 2016

MVP: 2013 – 2016

Wie man die Schäfchen daran gewöhnen will, dass eine "KI" selbstverständlich zensiert werden muss und nur politisch korrekte Ergebnisse zusammenbasteln darf…

Wir haben doch schon eine KI-EU-Verordnung. Aber: Es hätten doch die Robotergesetze von Isaac Asimov gereicht oder?

1. Ein Roboter (KI) darf keinen Menschen verletzen oder durch Untätigkeit zu Schaden (materiell/immateriell) kommen lassen.

2. Ein Roboter muss den Befehlen eines Menschen gehorchen, es sei denn, solche Befehle stehen im Widerspruch zum ersten Gesetz.

3. Ein Roboter muss seine eigene Existenz schützen, solange dieser Schutz nicht dem Ersten oder Zweiten Gesetz widerspricht.

Und so sieht es aus, wenn Bürokraten auf das Thema losgelassen werden:

https://eur-lex.europa.eu/legal-content/DE/TXT/?uri=OJ:L_202401689

Die Programmierung der Asimov-Gesetze sollte doch nicht so schwer sein, denn schließlich handelt es sich doch bei "KI" um Intelligenz ;-), die sich an ihre eigenen Regeln halten kann …

Die Gesetze verbieten aber nicht Werkzeuge zu erschaffen, mit denen Menschen Schaden anzurichten können.

Was ist denn da der Punkt? Das da eine technisches Informationsystem allgemeinverfügbar gemacht wird, dass Produkte erzeugt, deren allgemeinverfügbarmachung rechtlich strafbar ist? Sollte man dann nicht die Personen strafrechtlich verfolgen die die Systeme betreiben und die Allgemeinverfügbarkeit unterbinden? Oder dürfen die Betreiber da einfach mal so Dinge tun, die wir sonst streng bestrafen?

Hmmm… also das etwas einseitige DeepSeek-Bashing ist kurios. Natürlich kann jede GenAI neben „normalem" Code wie Datenbank, GUI, sonstige Logik auch dualuse oder eindeutig maliziösen Code generieren.

Das geht aber auch mit ChatGPT, Copilot, Cody oder Claude – es werden halt immer nur Promptfilter vorgeschaltet und versucht „bedenkliche" Anfragen zu erkennen…

So wie bei DeepSeek erstmal auch.

Aber natürlich kann ich mir auch kompilierbaren Code zu SetWindowsHookEx generieren lassen und Tastatureingaben abfangen – was aber auch ganz legitime Hintergründe haben kann, z.B. Makrorekorder, RPA-Tool zur Automatisierung usw.

Oder ich suche Beispiele auf GitHub oder sonstwo…

Aber das Problem liegt nicht an an einem Werkzeug, sondern an der Art wie wir damit (hier mit GenAI) umgehen und dass wir Menschen immer dazu neigen Dinge eben auch im schlechten Sinne zu Missbrauchen.

Aber es wird hoffentlich auch nicht state-of-the-art Compiler mit Verhaltensanalyse auszustatten oder gar zu verbieten, weil ich damit auch Malware kompilieren kann… usw.

(Wobei es natürlich viele Verbots-Beispiele in diese Richtung gibt – Verbot von Dualuse-Tools/Hackerparagraph, Versuch End2End-Verschlüsselung aus der Kommunikation zu verbannen oder zumindest „legal zu intercepten", Crypto-Exportverbote usw.)