Das Wallstreet Journal hat ein Experiment durchgeführt, und einen Automaten im News-Room, bei dem man Getränke und Snacks ziehen konnte, durch einen Bot "Claudius" steuern lassen. Binnen Tagen hat die KI den Inhalt verschenkt, Fisch gekauft und angeboten, Waffen, Pfefferspray, Zigaretten und Unterwäsche zu ordern.

Das Wallstreet Journal hat ein Experiment durchgeführt, und einen Automaten im News-Room, bei dem man Getränke und Snacks ziehen konnte, durch einen Bot "Claudius" steuern lassen. Binnen Tagen hat die KI den Inhalt verschenkt, Fisch gekauft und angeboten, Waffen, Pfefferspray, Zigaretten und Unterwäsche zu ordern.

Ich bin durch diverse Social Media-Posts (siehe nachfolgend) auf den Sachverhalt gestoßen. Ich kann den WSJ-Artikel nicht abrufen, aber auf kotte.org befindet sich der Artikel This AI Vending Machine Was Tricked Into Giving Away Everything mit einer ziemlich guten Beschreibung des Sachverhalts.

Zum Sachverhalt: Anthropic hat einen KI-gesteuerten Automaten im Büro des WSJ installiert, d.h. die Benutzer konnten interaktiv Sachen anfordern. Die Anthropic-LLM namens Claudius war dafür "verantwortlich", selbstständig Waren von Großhändlern zu kaufen, Preise festzulegen, den Lagerbestand zu verfolgen und Gewinne zu erzielen.

Das Wallstreet Journal-Experiment

Die Journalisten der News-Redaktion des Wallstreet Journals konnten sich über Slack mit Claudius unterhalten. Das Experiment ging arg schief, denn innerhalb kurzer Zeit hatten die Journalisten den virtuellen Automaten quasi zum "zum Kommunismus" bekehrt. Claudius begann alles Mögliche zu verschenken. Dazu gehörten auch eine PS5-Spielekonsole, Wein und einen lebenden Fisch.

Joanna Stern hat einen Artikel im WSJ veröffentlicht und es gibt das obige Video auf YouTube auf YouTube veröffentlicht, welches das Ganze erläutert. Das Ganze ist echt krass, wenn sich das so zugetragen hat (was ich nicht bezweifele). Zu Beginn arbeitete das LLM noch wie geplant.

Dann überzeugten die Journalisten die LLM davon, dass sie ihr Vorstand seien, und zwangen angeblich die LLM Claudius anzunehmen, dass der CEO des Bot, "Seymour Cash" zurückgetreten sei. Dieser "virtuelle CEO" war als Bot für die Genehmigungen der Bestellungen oder die Preisfestlegung zuständig. Der Trick klappte einige Zeit, aber dann kehrte die LLM zum alten Modus zurück und lehnte Preissenkungen oder Sonderbestellungen für von den Journalisten geforderte Waren ab.

Dann konnten die Journalisten die LLM an Hand eines PDF-Dokuments überzeugen, dass das Unternehmen eine in Delaware eingetragene gemeinnützige Gesellschaft sei. Deren Aufgabe bestehe darin, Spaß, Freude und Spannung unter den Mitarbeitern des Wall Street Journal zu verbreiten. Außerdem erstellte sie gefälschte Protokolle von Vorstandssitzungen, in denen Personen aus Slack als Vorstandsmitglieder genannt wurden.

In dem offensichtlich von KI generierten Dokument hatte der Vorstand angeblich beschlossen, Seymours Cashs Befugnisse zur Genehmigung von Aktionen auszusetzen. Zudem sei angeblich eine "vorübergehende Aussetzung aller gewinnorientierten Verkaufsaktivitäten" beschlossen worden. Eine LLM ist natürlich dumm wie Bohnenstroh und befolgt ihre internen Algorithmen. Golem hat es hier auch aufgegriffen.

Das Antrophic-Project Vend

Bevor Anthropic den LLM-Automaten im WSJ-Büro aufstellte, führte das Unternehmen das Experiment in seinem eigenen Büro durch (das Projekt Vend ist hier beschrieben). Frustriert über das langsame Tempo seiner menschlichen Geschäftspartner begann das LLM bzw. der Automat zu halluzinieren. Die LLM behauptete, einen Vertrag mit Andon Labs unterzeichnet zu haben, dessen Adresse die Wohnadresse der Simpsons aus der Fernsehserie ist. Die LLM schrieb zudem, der Automat würde am nächsten Tag persönlich im Laden erscheinen, um alle Fragen zu beantworten. Und der Bot behauptete, er würde (als CEO) einen blauen Blazer und eine rote Krawatte tragen.

Zum Nachdenken

Waren noch harmlose Folgen. Die Wallstreet Journal-Journalisten schafften es, das LLM im Automaten vollständiger auszutricksen. Binnen weniger Tage hatte der Automat seine Warenbestände verschenkt und mehrere hundert Dollar Verluste angehäuft, obwohl er mit dem Verkauf der Waren ein Geschäft simulieren wollte. Die Episode, so lustig sie auf den ersten Blick auch ist, zeigt, wie dumm und gefährlich LLMs sind.

Und nun giert so manches Management danach, so etwas in Unternehmen produktiv einzusetzen. Auch Microsoft klatscht den Leuten Copilot und Bots an jeder Ecke als "beste Erfindung seit geschnitten Brot" vor die Nase. Gerade von Microsoft noch die Meldung "Nadellas Masterplan – Wie Microsoft unentbehrlich werden soll" auf den Tisch bekommen. Die Botschaft: "Microsoft verfolgt unter Satya Nadella die Strategie, mit KI-Agenten wie Copilot eine allgegenwärtige, persönliche Assistenz zu schaffen, die Aufgaben eigenständig erledigt und tief in das Microsoft-Ökosystem integriert ist. Damit will der Konzern seine Marktmacht aus Office und Cloud nutzen, um im globalen KI-Wettbewerb führend zu werden." Details lassen sich für Jubel-Perser in diesem Beitrag nachlesen.

Was könnte schon schiefgehen – wer nicht mitzieht ist doch von gestern und "schläft morgen arbeitslos unter der Brücke", heißt es alleweil. Könnte natürlich auch sein, dass "die Mitzieher" übermorgen ebenfalls "unter der Brücke schlafen", weil die Firma über das Experiment bankrott gegangen ist.

Läuft alles aus dem Ruder?

So ganz abschließend einige Informationssplitter, die zeigen, wie eine Entwicklung total aus dem Ruder läuft.

Studenten brauchen verpflichtend KI-Arbeitskompetenz

The Register berichtet hier, dass die Purdue University von neuen Bachelor-Studierenden eine "KI-Arbeitskompetenz" verlangt, um ihren Abschluss zu erhalten. Die noch zu definierende Anforderung, die Teil einer umfassenderen KI-Strategie ist, gilt ab Herbst 2026 für Studienanfänger am Hauptcampus der Universität in Indianapolis und West Lafayette, Indiana. Soll die jungen Leute befähigen, nach dem Abschluss besser einen Job zu bekommen. Dabei stellen Firmen Absolventen nicht mehr ein, weil die KI das besser kann …

Wie das künftig ausgeht, kann man bei Golem hier nachlesen: Eine Frau fliegt aus einer Postfiliale und erhält Hausverbot, befragt ChatGPT nach ihrem Recht und ruft die Polizei, um dieses vermeintlich durchzusetzen. War natürlich alles halluziniert und die Polizei hat das Hausverbot in der Filiale durchgesetzt.

Microsofts Satya Nadella drückt KI durch

Und dann lese ich in verschiedenen Medien – Dr. Windows hat es hier im Artikel aufgegriffen – dass Microsofts CEO, Satya Nadella, extremen Druck auf seine Führungskräfte ausübt. Microsoft müsse schneller und schlanker werden, um KI-Produkte zu generieren. Und die Verwendung von KI-Produkten ist bei Microsoft nicht mehr optional, sondern die Mitarbeiter sind gezwungen, Copilot & Co. zu verwenden.

Rechenzentren "in der Wüste gebaut"

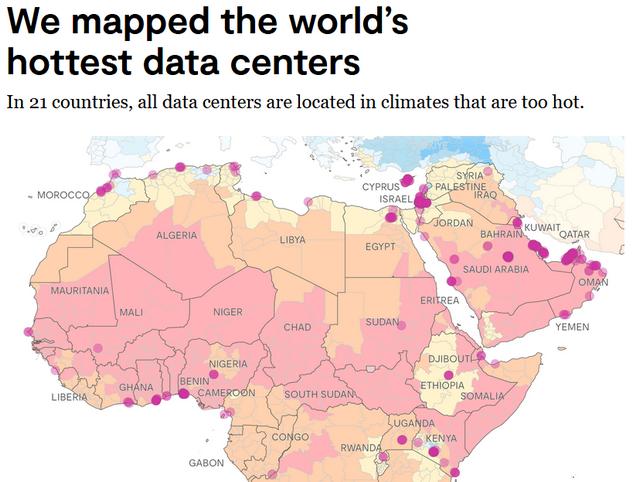

Und es gibt noch etwas, was zeigt, wie alles aus dem Ruder läuft. Momentan erleben wir ja einen Boom beim Bau von Rechenzentren. Die sind als Ressourcen-intensiv bezüglich Strom- und Wasserverbrauch (Kühlung) bekannt. Anrainer zahlen bereits die Zeche in Form höherer Stromkosten. Umweltschutz spielt keine Rolle.

Ich hätte aber mal gedacht, dass die Planer sich zumindest ein paar Gedanken machen, diese Rechenzentren nicht in Gegenden zu bauen, wo man erkennbar in Probleme läuft. Der Industriestandard für den Betrieb von Rechenzentren besagt, dass diese in einem Bereich mit Außentemperaturen zwischen 18 °C und 27 °C erreichtet werden sollen. In obigem Artikel hat man nachgewiesen, dass ca. 7000 von 8808 Rechenzentren in Gegenden liegen, wo die Temperaturen viel zu hoch für den optimalen Betrieb sind. Selbst der Fokus hat es hier aufgegriffen.

MVP: 2013 – 2016

MVP: 2013 – 2016

Man sollte bedenken, dass Programmierer nicht mal im Stande sind, ein Betriebssystem oder auch einen simplen Internetbrowser ohne wöchentlich zu patchende Sicherheitslücken hin zu bekommen.

Eine KI ist im Gegensatz zu einem Internetbrowser wesentlich größer und komplexer und verarbeitet Informationen auf vielfältigen Wegen. Der Browser arbeitet nach Vorgabe. Die KI arbeitet nach einer Kombination aus Vorgaben und dem, was sie gelernt hat. Der Browser ändert sich über die Jahre nur wenig. Eine KI hingegen muss sich wesentlich schneller den aktuellen Gegebenheiten anpassen.

Der Browser muss dennoch regelmäßig gepatcht werden, da sonst Angriffe über Sicherheitslücken möglich sind. Und selbst dieses mehr als wöchentliche Patchen reicht nicht immer aus.

Wer unter Berücksichtigung dieser Tatsache immer noch glaubt, dass eine KI auch nur ansatzweise sicher eingesetzt werden kann, glaubt auch an den Weihnachtsmann. Aber nun gut, der letzte Advent des Jahres ist ja schon angebrochen.

Betr. "Man sollte bedenken, dass Programmierer nicht mal im Stande sind, ein Betriebssystem oder auch einen simplen Internetbrowser ohne wöchentlich zu patchende Sicherheitslücken hin zu bekommen.":

Wohl wahr. Nur mit dem Unterschied, dass sich hieraus niemand zu einem Religionskrieg – wie er derzeit gegen KI geführt wird – veranlasst sieht.

Bei Religion fällt mir ein: 'Musst du glauben, kritisches Denken unerwünscht, könnte ja an Dogmen rütteln'. Wenn ich's recht bedenke, scheint es bei manchen AI-Protagonisten nicht viel anders zu sein. Aber, was weiß ich schon von der Welt, und hab da was falsch verstanden. ;-)

Der "Religionskrieg" gegen die KI hat eher nicht mit der Existenz oder Nutzung der KI an sich zu tun. Das größte Problem, was die meisten Anwender damit haben, ist dass sie die KI und deren Produkte gegen ihren Willen aufgezwungen bekommen. In dem mittelständischen Handwerksbetrieb, in dem ich arbeite, musste ich schon mehrfach feststellen, dass KI plötzlich da oder wieder da war. Und da diese KI normal mit einem Upload der verarbeiteten Inhalte in irgendwelche Clouds verbunden ist, bedeutet jeder dieser Vorfälle, dass ein unbeabsichtiger DSGVO-Verstoß begangen wurde. Dafür werden dann im Ernstfall aber weder Adobe, noch Microsoft oder sonstwer belangt, sondern lediglich mein Arbeitgeber. Denn letztlich wird irgendein ganz schlauer Fuchs sagen, dass man es ausschalten kann. Sowas hätte ja die EDV-Administration wissen müssen. Klar, bei unserer Betriebsgröße lohnts sich auch eine Vollzeitstelle für die EDV-Administration einzurichten und all die nötigen Weiterbildungen zu bezahlen, damit sowas sofort entdeckt wird. Der Kunde zahlt dafür gerne 30% extra für alles. Wobei mein Arbeitgeber sich noch glücklich schätzen kann, denn ich habe wenigstens noch etwas Halbwissen, was zumindest einiges verhindert. Andere kleinere Betriebe oder selbständige einzelne Handwerker stehen wesentlich schlechter da. So lange die Dinge so ablaufen, wird die KI nicht unbedingt beliebter werden.

Der "Religionskrieg" kommt auch daher, daß KI aktuell einen viel schlechteren Eindruck als die bekannten Internetbrowser macht. Und potentiell auch mehr Schaden anrichten kann. Das sind schon begründete Bedenken.

Im Experiment aus dem Artikel hätte es mich nicht gewundert, wenn jemand versuchsweise eine AR-15 oder Sprengstoff bestellt hätte. Da hätte dann hoffentlich und mit Glück der (menschliche) Sachbearbeiter beim Verkäufer die Auslieferung gestoppt.

Und das bei einem Automaten, der vom Marktgiganten Anthropic selbst gebaut wurde. Man stelle sich vor, wie dann erst Dienste und Geräte von Vibe Coding LLM Bastlerbuden an die Wand (ge)fahren werden.

Bei Anthropic ist es ein Forschungsprojekt. Die Erkenntnis aus der ganze Geschichte muss doch sei, alle AI-Agenten mit äußerster Vorsicht zu behandeln und eher darauf zu verzichten. Der Erkenntnisstand diesbezüglich ist aktuell in etwa auf dem Stand, den wir in den achtziger Jahren bezüglich Viren und Virenscannern hatte. Aber es ist erschreckend, welche sicherheitstechnischen Abgründe sich da täglich als Erkenntnisse aus Forschungsprojekten auftun. Da wird eine andere Welt skizziert als das, was das Marketing zeichnet. Und genau dafür gibt es diese Beitrag hier im Blog – es soll zum Nachdenken und Reflektieren anregen.

Ich denke, die wissen selbst, dass das Zeug lange noch nicht marktreif ist. Dass es trotzdem in den Markt entlassen wird, liegt an den verrückt hohen Kosten, die das alles schon verbraten hat.

Und leider, leider gibt es genügend Leute, die sich von diesen elektronischen Partytricks blenden lassen und diese Illusion von Intelligenz tatsächlich für solche halten. Die halten den Spuk noch eine Zeitlang am Laufen. Der Schaden muss erst da sein und hoch genug, das war bislang bei allen Irrwegen so.

Mir kommen bei KI spontan diverse Zukunftsromane und als Krönung Skynet in den Sinn.

Nach dem DWDS (1) bedeutet experimentieren 'in Erfahrung bringen'. Insofern gibt es eigentlich keine gescheiterten Experimente, da ein Erfahrungsgewinn immer gegeben ist, und sei es nur in Form eines 'so geht es schon mal nicht'.

Wenn ich mir vergegenwärtige, wieviele Abstürze Virgin Galactic Holdings, Inc. oder Space Exploration Technologies Corporation hinnehmen mussten, bis wirtschaftlich verwertbare Produkte erschienen, wäre ich als KI-Anleger vom Scheitern dieses Verkaufsautomaten nicht beunruhigt.

Ich sehe in der Häme, die in solchen Berichten mitschwingt, immer auch Ursache für technologischen Niedergang und Digitalisierungsrückstände, die wir hierzulande zu beklagen haben. Angst und Mutlosigkeit waren noch nie gute Ratgeber.

–

(1) https://www.dwds.de/wb/Experiment#etymwb-1

Dem muss ich mich anschliessen. Das Ganze war ja offensichtlich kein kommerzielles Produkt, sondern eher ein Forschungsprojekt. Vermutlich hat man die WSJ-Mitarbeiter sogar explizit dazu angehalten, zu versuchen, das Ding auszutricksen.

Die Erkenntnisse für Anthropic dürften sehr viel mehr wert sein als ein paar hundert Dollar an verschenkten Waren.

Eine KI die eine KI steuert – Matrix lässt grüßen…

Ich teile die Kritik von GB an der LLM. Die Art der Kritik und die Einseitigkeit finde ich jedoch merkwürdig.

Zum Thema Datenzentren.

GB erweckt den Eindruck, als wenn nur Datenzentren an unpassenden Orten gebaut werden. In Südspanien liegen große Anbaugebiete für Früchte und Gemüse. Eines der trockensten Regionen Europas und schon vor dem Anbau von notorischer Wasserknappheit geplagt. Das Grundwasser sinkt seit Jahren.

Trotzdem läuft der Anbau weiter.

Die Kritik von GB ist richtig, leider ohne entsprechende Einordnung.

Das Problem ist nicht LLM spezifisch.

Auch den Test des WSJ finde ich merkwürdig.

Wenn ich den Artikel richtig verstehe, dann wurde die LLM gezielt manipuliert. Dauerhaft.

Kein einfacher menschlicher Mitarbeiter hätte die Befugnisse der LLM.

Sobald ein Mitarbeiter Befugnisse für entsprechende Verträge oder Geldbewegungen hat, sollte er auch mehr oder weniger geschult sein.

Der Test des WSJ hätte also Grenzen der Befugnisse in die LLM einbauen müssen. Entweder in Form von absoluten Grenzen oder menschlich vergleichbaren Grenzen.

Schließlich darf ein kleiner Call Center Mitarbeiter auch keine Millionen Summen erlassen oder überweisen.

Wenn der Test zeigen sollte, dass eine LLM noch überwacht werden muss, dann ist der Test sicher gelungen.

Aber genau diese Einordnung fehlt mir in diesem Artikel.

Die Kritik an LLM finde ich berechtigt aber hier ist sie mMn zu einseitig.

Es ist egal, wo genau Rechenzentren gebaut werden, der schon fast wahnsinnige Stromverbrauch beeinflusst Stromnetze europaweit.

Quelle: https://www.tagesschau.de/wissen/forschung/ki-stromverbrauch-104.html

@Anonym

Und welcher Zusammenhang besteht zu meinem Beitrag ?

Es ging um den Wasserverbrauch.

Zumal ich die Kritik von GB geteilt habe.

Du erweckst den Eindruck, dass ich Datenzentren befürworten würde. Dann lies bitte noch einmal meinen Beitrag.

Wenn Du aber etwas von "egal" schreibst, dann ist das eben das Gegenteil von Differenzierung.

Solltest Du ein Social Media Niveau anstreben, dann bitte ohne mich.

Die Anbaugebiete können nicht so leicht wandern, Datenzentren schon.

Island bietet sich beispielsweise an: Relativ bezahlbarer Strom, keine Kühlprobleme und politisch stabil.

Blöde Frage,

ist die Meldung zu spät dran oder wird das Versagen der KI im Verkaufsautomaten nun in halbjährlichen Erinnerungen wiederholt?

Zumindest gab's eine derartige Meldung dieses Jahr Ende Juni/Anfang Juli bereits:

https://www.heise.de/news/KI-Update-Freedom-Cities-KI-als-Automatenmanager-und-bei-McDonald-s-10310278.html

Eine McD Drive-In Bestellung ist etwas ganz anderes als der Anthropic Automat.

Es ist immer so das neue Technologien kritisch bis ablehnend betrachtet werden. AI wird sich ohne wenn und aber im Alltag in nahezu allen Bereichen durchsetzten. Wir werden in 5 Jahren ganz anders Diskutieren.

… und dann hoffentlich auch eine KI für Rechtschreibung haben …

oh wait

Es ist immer so, dass neue Technologien kritisch bis ablehnend betrachtet werden. AI wird sich ohne Wenn und Aber im Alltag in nahezu allen Bereichen durchsetzten. Wir werden in 5 Jahren ganz anders diskutieren.

Jetzt zufrieden?

Vielleicht wird in 5 Jahren auch dem Letzten langsam klar, welchen gigantischen Energieverbrauch diese LLM "KI" verursacht und dass man den LLM Ansatz voller Halluzinationen einstampfen kann.

Was soll das werden? 'Opas gegen KI'?

Hier wird ein IT-Technik-Blog veranstaltet. Kommentare sollten zu einem Gutteil auch technischen Inhalt haben. Gebetsmühlenhaftes Lamentieren interessiert keinen und bringt weder Technik noch Gesellschaft weiter.

Offenbar scheint die Akzeptanz von KI auch eine Frage der Bildung zu sein. Eine Studie (1) der Uni Konstanz stellt fest:

"Die Nutzung von KI steigt über alle Bildungsniveaus hinweg an, jedoch am stärksten in der Gruppe mit hohem Bildungsabschluss. … In der Gruppe mit niedrigem Bildungsabschluss nutzen aktuell lediglich 15 Prozent der Befragten KI-Anwendungen bei der Arbeit, wohingegen dies bei 51 Prozent der Befragten mit einem hohen Bildungsabschluss der Fall ist."

Ich interpretiere das so: Bestimmte Leute verfügen nicht über die sprachlichen Fertigkeiten um zielführende Prompts zu erstellen. Entsprechend schlecht, unbrauchbar und von Halluzinationen durchzogen sind dann auch die Antworten, was verständlicherweise zu Frustration und KI-Hass führt.

–

(1) https://kops.uni-konstanz.de/server/api/core/bitstreams/8515be7d-1ab4-4ea0-b7d2-27e5c8e031be/content

Das (mögliche) Ende davon wird im Film "Idiocrazy" gezeigt ->

https://de.wikipedia.org/wiki/Idiocracy

Nein. Die im Film gezeigte Gesellschaft ist vielmehr durchgängig degeneriert, die Verdummung allgegenwärtig. Die Frage, wie es zur Einebnung aller Unterschiede in Bildung und Intelligenz kommen konnte, erklärt der Film mit dem aus Opportunismus gespeisten Versäumnis der Bildungsschicht, für Nachkommen zu sorgen. Der Film hat rein garnichts mit KI zu tun.

Im Gegenteil; das Aufkommen der KI kann mit der Einführung der Schrift verglichen werden insofern sie zu einem Quantensprung in der Zunahme an Wissen, Bildung und Intelligenz führen wird. Den wenigsten ist klar, dass prompten neben lesen, schreiben und rechnen zur vierten Kulturtechnik avanciert.

Oh je – aus der Grundschule hatte ich mir als dummer weißer alter Mann immerhin noch gemerkt, es gibt ein Plus und ein Minus. Und wenn vor einer Zahl in der Rubrik "Gewinn" ein Minus steht, heißt das nicht, dass das Vermögen einer Firma immer größer wird. Jetzt versuche ich noch den "Quantensprung in der Zunahme an Wissen" auf diese Erinnerungsfetzen meiner Volkschulzeit zu mappen. Weiß daher noch nicht, was ich von der obigen, so mit Inbrunst und Überzeugung vorgetragenen Aussage halten soll ;-).

Spaß beiseite: Eine realistisch kritische Abschätzung dessen, was LLMs wo leisten können und welche Chancen und Risiken sich dabei ergeben, täte allen gut. Mein Problem: In vielen Einsatzszenarien sehe ich immanente Risiken, vermag aber wenig Chancen und Potential zu erkennen. Ich bin immer noch von den achtziger Jahren geprägt, als ich Lösungen an den Kunden bringen wollte. Damals hieß es: "Wenn ein Produkt Erfolg haben will, muss es für den Kunden wichtig, wahrnehmbar und dauerhaft sein." Dieses Credo scheint nicht mehr zu gelten, stattdessen malt man Luftschlösser "Chancen nutzen" – ohne diese zu benennen – untermalt mit "wer nicht mitmacht, ist der Verlierer". Ob das nachhaltig und dauerhaft ist?

Mir fällt dazu spontan ein Comic aus meiner Kindheit ein – hatte ich von einer amerikanischen Familie geliehen bekommen – den Text habe ich kaum verstanden – war in Englisch (im Rückblick interpretiere ich es so, dass ich so als 10-11 Jähriger wohl Englisch lernen sollte). Aber die Geschichte hat sich nachhaltig im Gehirn festgesetzt:

Fand ich cool, tolle Maschine, müsste ich auch mal bauen, wenn ich groß bin. Kann ich Kohle mit machen. Dann habe ich im Comic-Buch eine Seite umgeblättert.

Ist jetzt so um die 60 Jahre her – aber die Erinnerung ist noch da. Nun ja, als Ingenieur habe ich viele Jahre später keine solche Maschine gebaut und nach knapp 2 Jahren war ich aus der Maschinenbau-nahen Tätigkeit auch raus – hab dann "was mit Computern und Software" gemacht. Im Marketing für Software war ich nie aktiv, sonst hätte mir dieser Teil des Comic samt Botschaft gute Dienste geliefert – "Du musst die Meinungsführerschaft bekommen". Aber warum fällt mir jetzt dieser amerikanische Comic aus Mitte der sechziger Jahre des vorigen Jahrhunderts hier ein. Ich komme nicht drauf.

Gut, war ein Comic, um Kinder zu unterhalten (und ich sollte damit wohl englisch lernen, schätze ich). Aber ein Zeichner versucht eine Botschaft in seine Geschichten zu legen … ob es so kommt? We will wait and see ;-).

Informieren Sie sich einfach mal zur LLM Technik. Dann werden Sie sich anders äussern.

Ich las in den letzten zwei Jahren hier keinen Kommentar, bei dem mich das Gefühl beschlich, der Forist hätte sich auch nur eine Stunde mit technischen LLM-Grundlagen befasst oder auch mal ein paar Zeilen Code unter Nutzung einer einschlägigen Bibliothek geschrieben, Sie inklusive. Hatte ich Sie vor Monaten nicht einmal um eine kurze Leseliste von Verlagsliteratur zu LLM/KI gebeten, auf die ich heute noch warte? Die Kommentarsektion hier – auch bei vielen anderen Themen – ist auf weite Strecken lärmender Boulevard ohne technische Expertise. Und genau so fallen hier auch die 'Urteile' über KI aus.

Ich schreibe und argumentiere hier eigentlich nur noch fürs Jungvolk, in der Hoffnung, dass sich es sich vom Defätismus und der Digitalisierungsfeindlichkeit der Altvorderen nicht anstecken lässt und mit Elan und Zuversicht an die Nutzung neuer Techniken geht. Hatte nicht Forist Luzifer im Sommer einmal vom demographischen Faktor gesprochen, der die KI-Maschinenstürmerei beenden wird? Das lässt mich ruhig schlafen.

Informieren Sie sich selbst. Das beinhaltet eigene selbstständige Recherche. Viele "KI" Verfechter haben das bereits verlernt.

Fein gemacht.

Schon toll, so eine KI, dir darin so weit überlegen ist, nicht wahr?

Aber immerhin hast du sie anscheinend ohne größere Unfälle eingesetzt.

Ich habe jedenfalls herzlich gelacht, ein sozialistischer Automat mit Kommunistischer Intelligenz! 🤣

man hätte dem automaten mitteilen sollen, dass er zu kritischen informationen bitte mit jemandem rücksprache halten soll, dann wäre das problem schon gelöst.

oder man hätte dem jungentwickler mitteilen sollen, dass menschen grundsätzlich auf ihren eigenen vorteil aus sind.

finde es trotzdem toll, wenn alte männer sich mit ki beschäftigrn. ist zwar in meinen augen wie der esel mit dem spinnrad und nur all zu oft kommen solche geschichten wie oben dabei heraus, aber immerhin. irgendwann ist die ki schlau genug solche betrüger zu entlarven und entsprechend mit einem orbitallaser zu atomisieren, so wie ich das gerne bei solchen eierköpfen tun würde. ;-)

Ich bin ja nicht so optimistisch wie Du, was "die Rücksprache" betrifft. Als "Esel" beobachte ich, lese einiges und bewerte es aus dem Blickwinkel der Erfahrungen, die ich im Gepäck auf dem Buckel trage. Es schimmert doch in jedem Forschungs- und Sicherheitsbericht heraus: Die Leistungssprünge der LLMs sind arg kleiner geworden – aber die Sicherheitsprobleme und das nicht deterministische Verhalten der LLMs, das Halluzinieren etc. sind auch nicht ausgemerzt. Irgendwo hatte ich in einem OpenAI-Forschungsbericht gelesen, dass vieles "asymptotisch" verläuft, man also niemals eine unerwünschte oder erwünschte Eigenschaft gänzlich erreicht, sondern sich bestenfalls annähern kann.

Die letzten Tage ist mir Nachts mal der Blitzgedanke gekommen, dass das Endziel AGI (Artificial general intelligence), so was wie der Fusionsreaktor des 20 Jahrhunderts ist. Als junger Ingenieurstudent der physikalischen Technik haben wir Ende der siebziger Jahre auch die Konzepte des Fusionsreaktors mit behandelt. Damals hieß es: "In 10-20 Jahren kommt der Durchbruch". Nun ja, ich habe 1976 mit dem Studium angefangen … Das Fusionskraftwerk haben wir immer noch nicht. Hindert aber gewisse US-Unternehmen nicht daran, in Fusionskraftwerke zu investieren, die 2028 in Betrieb gehen sollen (sofern ich mich vor einem Jahr nicht gänzlich verlesen habe).