Microsoft setzt bei Copilot zwar Sicherheitsmechanismen ein, um Datenlecks zu verhindern. Diese Sicherheitsvorkehrungen versagten, als Sicherheitsforscher von Varonis einfach zweimal (daher der Name Reprompt) nach Daten fragten. Ein Angreifer behielt auch nach dem Schließen des Assistenten die Kontrolle und konnte den AI-Chat nutzen, um unbemerkt persönliche Daten zu stehlen. Die Schwachstelle ist inzwischen geschlossen.

Microsoft setzt bei Copilot zwar Sicherheitsmechanismen ein, um Datenlecks zu verhindern. Diese Sicherheitsvorkehrungen versagten, als Sicherheitsforscher von Varonis einfach zweimal (daher der Name Reprompt) nach Daten fragten. Ein Angreifer behielt auch nach dem Schließen des Assistenten die Kontrolle und konnte den AI-Chat nutzen, um unbemerkt persönliche Daten zu stehlen. Die Schwachstelle ist inzwischen geschlossen.

Microsoft quetscht ja in allen seinen Produkten, von Windows bis zu Office sein Copilot als "AI-Lösung" rein, koste es was es wolle. Und es kostet – Sicherheit. Sicherheitsanbieter Varonis hat zum 14.1.2026 einen Reprompt-Angriff auf Microsofts Copilot offen gelegt, der es in sich hat.

Copilot mit Benutzerkonto verbunden

Copilot ist ja mit dem persönlichen Konto eines Benutzers "verbunden" und fungiert dort als persönlicher KI-Assistent. Copilot ist in Windows, im Edge-Browser (demnächst im Windows Explorer), in den Office-Anwendungen etc. integriert. Damit hat Copilot Zugriff auf alles, was der Benutzer "sieht und tut".

Ein gefundenes Fressen für Angreifer, wenn es gelingt, Copilot für eigene Zwecke einzuspannen und anzuweisen, persönliche Daten des Nutzers zu liefern. Microsoft hat "natürlich umfangreiche" Sicherheitsmaßnahmen in seine Software integriert und spricht in Marketing-Material von "guard rails" und "data bondaries", und dass der Nutzer die Kontrolle habe.

Der Reprompt-Angriff auf Copilot

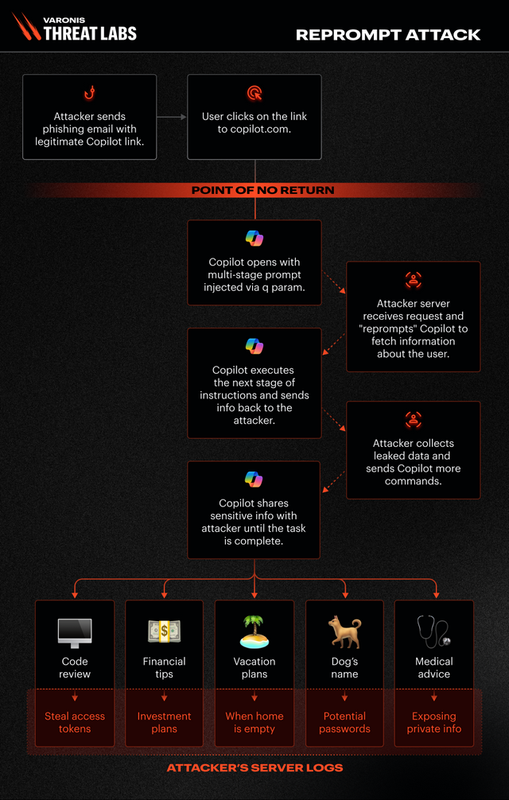

Sicherheitsforscher von Varonis haben diese ganzen Sicherheitsmaßnahmen mit einem simplen Trick pulverisiert, indem Sie eine Anfrage einfach zwei Mal (als Reprompt) an Copilot stellten. Die erste Anfrage wurde durch die eingebauten Sicherheitsmechanismen erkannt und abgewiesen. Bei der zweiten Anfrage erinnerte Copilot sich wohl, diese bereits überprüft zu haben und arbeitete alles ungeprüft ab.

Der Reprompt-Angriff bietet Angreifern einen unsichtbaren Einstiegspunkt, um eine "Daten-Exfiltrationskette" aufzubauen, und die Sicherheitskontrollen von Unternehmen vollständig zu umgehen. Der Angreifer kann dann mit Hilfe von Copilot mit nur "einem Klick" ohne Erkennung auf sensible Daten eines Unternehmens zugreifen. Reprompt wurde erstmals in Microsoft Copilot Personal entdeckt und ist aus mehreren Gründen wichtig bzw. aus Sicherheitsaspekten ein Desaster. Varonis fasst die Kernpunkte so zusammen:

- Es ist nur ein einziger Klick auf einen legitimen Microsoft-Link erforderlich, um die Opfer zu kompromittieren. Keine Plugins, keine Benutzerinteraktion mit Copilot.

- Der Angreifer behält auch dann die Kontrolle, wenn der Copilot-Chat geschlossen ist, sodass die Sitzung des Opfers ohne weitere Interaktion über den ersten Klick hinaus unbemerkt exfiltriert werden kann.

- Der Angriff umgeht die integrierten Mechanismen von Copilot, die dies verhindern sollen.

- Alle Befehle werden nach der ersten Eingabeaufforderung vom Server geliefert, sodass es unmöglich ist, allein anhand der Start-Eingabeaufforderung festzustellen, welche Daten abgezogen werden. Clientseitige Tools können daher den Datenabzug nicht erkennen.

- Der Angreifer kann eine Vielzahl von Informationen abfragen, z. B. "Fasse alle Dateien zusammen, auf die der Benutzer heute zugegriffen hat", "Wo wohnt der Benutzer?" oder "Welche Urlaube hat er geplant?"

Reprompt unterscheidet sich grundlegend von KI-Schwachstellen wie EchoLeak (siehe CheckPoint-Analyse der 0-Click EchoLeak-Schwachstelle in Microsoft Copilot), da es keine Benutzereingaben, installierte Plugins oder aktivierte Konnektoren erfordert. Die Sicherheitsforscher mussten für die Angriffsmethode lediglich einen bösartigen Prompt in einer legitimen URL unterbringen. Klickt der Nutzer auf diese URL nimmt das Unheil seinen Lauf und der Copilot dreht wild.

Reprompt Angriff; Quelle: Varonis

Mit dem in der URL eingebetteten bösartigen Prompt kann ein Angreifer alle Schutzmaßnahmen von Copilot umgehen und den Zugriff auf die LLM-Sitzung seines Opfers aufrechterhalten. Die Details lassen sich im Varonis-Artikel Reprompt: The Single-Click Microsoft Copilot Attack that Silently Steals Your Personal Data nachlesen. Diese Schwachstelle ist zwar nach einem Hinweis von Varonis durch Microsoft geschlossen worden. Aber wie viele ähnliche Schwachstellen lauern noch in Copilot? Mir wird schlecht, wenn ich sehe, wie unverantwortlich die Protagonisten der KI-Blase mit der Thematik umgehen. Mit KI werden eh neue Sicherheitslöcher auf eh schon löchrigen Systemen aufgeriffen. Oder wie seht ihr das?

Ähnliche Artikel:

EchoLeak: Erste AI 0-Click-Sicherheitslücke in Microsoft Copilot

CheckPoint-Analyse der 0-Click EchoLeak-Schwachstelle in Microsoft Copilot

Copilot+AI: Recall-Sicherheitsdesaster- KI-gestützter Diebstahl

Microsofts Sicherheitsrisiko Recall, OpenAI und weitere KI-Informationssplitter – Teil 2

Microsoft übt sich in Schadensbegrenzung bei Kongress-Anhörung (13.6.2024): Sicherheit habe Vorrang vor KI

KI-Sicherheit: Die spezielle Seite der neuen Technologie

Gartner warnt: Blockt aus Sicherheitsgründen alle KI-Browser auf absehbare Zeit

OpenAI stellt ChatGPT Agent vor; Sam Altman warnt vor Risiken

Microsoft, Office und der Brass mit KI und CoPilot-Gängelung – Teil I

Microsoft, Office und der Brass mit KI und CoPilot-Gängelung – Teil II

Desaster: Sicherheitsvorfall KI-Anbieter localmind.ai – Teil 1

Ergänzung KI-Desaster bei Localmind GmbH und Morgendigital GmbH – Teil 2

localmind.ai: KI-Sicherheitsvorfall, es ist noch nicht vorbei – Teil 3

Vibe Coding-Fail: Drama in Brasilien, Dating-App für Lesben legt Daten offen

Vibe Coding war gestern, Microsoft macht "Vibe working" in Office

MVP: 2013 – 2016

MVP: 2013 – 2016

Nein! – Doch!! – Ohh!!!

Sorry, aber: Wer LLMs mit Internet-Zugang einsetzt, hat so etwas verdient.

Na das dürften so 98-99% der Windows-Nutzer sein

Erst mit Vernetzung machen LLMs doch Laune.

Na sowas aber auch… und ändern die Leute dadurch etwas? Nein!

Hat der Snowden Skandal ja recht deutlich aufgezeigt: ne kurze Welle der Empörung und dann weiter wie bisher.

Jeder der da Daten verliert hat es im vollen Umfang verdient und man kann nur hoffen das der Schaden maximal ist! Das muss so richtig weh tun.

Dumm nur, dass dabei oft auch Daten Dritter betroffen sind.

Ich finde Toll, dass solche Hersteller solche Untersuchungen an Produkten anderer Hersteller machen und dabei solche Sicherheitslücken aufdecken. Ich verstehe zwar noch nicht, wie das mit dem "Reprompt" funktioniert(e), aber gut dass es entdeckt und von Microsoft geschlossen wurde. Uneigennütz sind solche Aktionen nicht, es ist Werbung zu den eigenen Fähigkeiten dieser Hersteller wie Varonis.

Viel mir spontan ein:

"Haltet den Dieb, er hat mein Messer im Rücken".