Das Jahr 2026 dürfte essentiell für die Protagonisten des KI-Hypes werden. Gerade zum Jahresanfang sind mir einige Meldungen untergekommen, die darauf hindeuten, dass wir so langsam erste Zeichen sehen, dass die KI-Blase platzt. Es gibt keinen Nachweis, dass KI Vorteile im betrieblichen Alltag bringt. Neue KI-Rechenzentren werden wegen fehlender Handwerker und fehlender Energie nicht gebaut werden können. Und OpenAI könnte in einigen Monaten die Pleite drohen. Derweil schwelgt manches Management weiter in seiner eigenen Blase.

Das Jahr 2026 dürfte essentiell für die Protagonisten des KI-Hypes werden. Gerade zum Jahresanfang sind mir einige Meldungen untergekommen, die darauf hindeuten, dass wir so langsam erste Zeichen sehen, dass die KI-Blase platzt. Es gibt keinen Nachweis, dass KI Vorteile im betrieblichen Alltag bringt. Neue KI-Rechenzentren werden wegen fehlender Handwerker und fehlender Energie nicht gebaut werden können. Und OpenAI könnte in einigen Monaten die Pleite drohen. Derweil schwelgt manches Management weiter in seiner eigenen Blase.

Handwerkermanagel behindert KI-Rechenzentrumsbau

Verfolgt man die Meldungen der großen Tech-Firmen oder AI-Protagonisten, werden in den kommenden Jahren ganze Landschaften mit KI-Rechenzentren zugepflastert, um die vermeintlich benötigte gigantische KI-Rechenleistung irgendwo anbieten zu können. Diese Phantasien haben zumindest in den USA gerade einen erheblichen Dämpfer bekommen. Dort fehlen schlicht die benötigen Handwerker, um die Rechenzentren zu bauen.

Bei Wired ist gerade der Artikel The Real AI Talent War Is for Plumbers and Electricians (ggf. nicht frei lesbar) erschienen. Die kompakte Botschaft des Beitrags lautet: "Der wahre Kampf um KI-Talente findet bei Klempnern und Elektrikern statt. Denn der KI-Boom befeuert zwar Pläne für eine beispiellose Welle von Rechenzentrumsbauprojekten. Aber in den USA gibt es nicht genügend qualifizierte Fachkräfte, um mit dieser Entwicklung Schritt zu halten."

Die "AI-Revolution" startet also mit gezogener Handbremse, weil der Elektriker oder der Klempner fehlt, um das Klo fertig zu stellen oder die Rechner anzuschließen. Bei T3N ist der deutschsprachige Artikel Fachkräftemangel: Warum in der KI-Branche gerade Elektriker und Klempner fehlen erschienen, der dieses Thema aus dem Wired-Beitrag aufgreift.

Abseits des obigen Themas liegen die Preissteigerungen und Komponentenknappheit bei Speichern noch als "road blocks" auf dem Weg zum "allumfassenden KI-Einsatz". Alleine dies wird einiges in der Entwicklung schlicht abwürgen – und nach den mir vorliegenden Informationen könnte diese Problematik bis ins Jahr 2028 andauern.

Der KI-Boom wird an der Energie scheitern

Zum 19. Januar 2026 ist in der Welt ein Artikel mit dem Titel "Energieverbrauch von KI wird an eine Grenze stoßen" erschienen (leider Paywall, daher nicht verlinkt). Der Inhalt des Beitrags hat in meinen Augen Hand und Fuß. Martin van den Brink, langjährige Technologiechef des niederländischen Chipmaschinenkonzerns ASML, warf auf dem DLD-Forum ("Digital, Life, Design", DLD, ist die internationale Konferenz- und Innovationsplattform von Hubert Burda Media) einen Blick auf das Thema "wie viel Energie braucht man eigentlich, damit die KI-Rechenzentrumsphantasien der Branche Realität werden".

Seine nüchterne Aussage: Wenn es nicht gigantische technologische Sprünge gibt, die den Energieverbrauch von KI-Chips dramatisch reduzieren, wird "der Energieverbrauch von KI wird in absehbarer Zeit an eine Grenze stoßen, die gesellschaftlich nicht mehr tragbar ist – wahrscheinlich innerhalb der nächsten zehn Jahre".

Ich hatte 2024 bereits im Artikel Der KI-Ressourcenverbrauch wird Stromnetze und Länder überfordern ein Kernproblem angesprochen: "Wo kommt die Energie zum Betrieb der ganzen KI-Rechenleistung her?". Wenn es um dieses Thema ging, konnte man 2025 in den Medien lesen: "Kein Problem, die großen Techfirmen kaufen sich ein stillgelegtes AKW oder bauen ein neues (Gas-)Kraftwerk neben das Rechenzentrum, und das Problem ist gelöst". Mancher Artikelschreiber verstieg sich sogar noch dazu, dass Firmen wie Microsoft darauf setzen, dass man 2028 Fusionskraftwerke zum Betrieb der Rechenzentren habe (2023 ist so was bei heise zu lesen gewesen, wobei das Thema eine breite Spur zog).

Martin van den Brink seziert aus seiner Sicht die Bruchstellen der Entwicklung. Laut Brink habe sich die weltweite Energieerzeugung den vergangenen zwanzig Jahren zwar verdoppelt. Diese Entwicklung sei viel zu langsam, um mit dem KI-Energiebedarf mitzuhalten.

- Die benötigte Rechenleistung steige aktuell alle zwei Jahre um den Faktor 16, sagt Brink. Wenn man heute ein KI-Rechenzentrum baut und ein (Gas-)Kraftwerk zur Energieversorgung daneben errichtet, mag das noch klappen.

- Aber das lasse sich nicht skalieren, in zwei Jahren müsse man dann 16 Kraftwerke neben das Rechenzentrum bauen, um die Energieversorgung sicherzustellen.

- Schreibe man die bisherigen Trends fort, könnte es 2035 zu der Situation kommen, dass das einmalige Training eines einzelnen dann aktuellen KI-Modells die gesamte Jahresproduktion globaler Energie verbrauchen würde, war eine der im Welt-Artikel zitierten Aussagen von Brink.

Brink konstatiert "Ein KI-Trainingswachstum um den Faktor 16 alle zwei Jahre ist nicht nachhaltig. Zwischen dem heutigen Wachstum des KI-Trainings und dem energetisch gesellschaftlich Tragbaren klafft eine Lücke von etwa dem Faktor zehn." Brink, der inzwischen den Aufsichtsrat von ASML berät, glaubt zwar, dass man bei KI-Chips noch optimieren könne. Wenn ich seine Ausführungen richtig interpretiere, plädiert er aber dafür, menschliches Fachwissen stärker in die Entwicklung von KI-Systemen einzubinden – und nicht, wie bisher, auf "immer größere Datenmengen" beim Training von Modellen zu setzen.

Möglicherweise gibt es technologische Durchbrüche (chinesische Entwickler von DeepSeek haben Anfang 2025 gezeigt, dass sich Rechenmodelle auch mit weniger Aufwand als bei der US-Konkurrenz trainieren lassen). Aber die "road blocks" der Physik, die ich oben aufgezeigt habe, liegen nach wie vor herum und könnten zum Killer der hochfliegenden Träume werden.

Kein Nachweis von KI-Nutzen

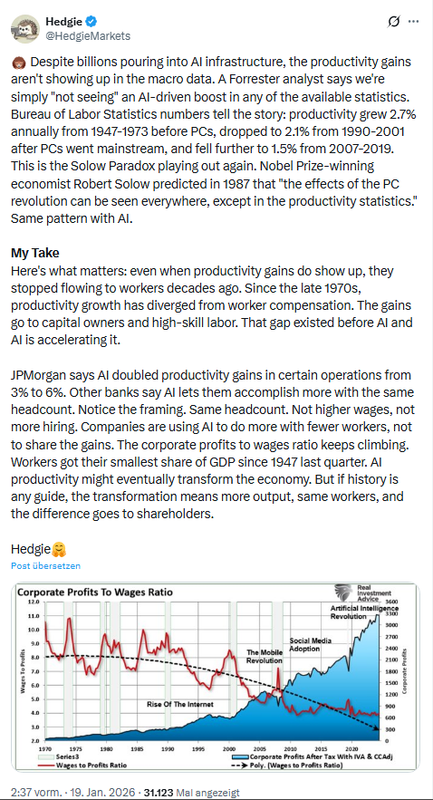

Kommen wir zu einem springenden Punkt in der Debatte um die Zukunft von KI: Irgendwer muss die Party bezahlen, und Firmen werden nur weiter auf das Thema setzen, wenn sich Vorteile ergeben. Mir ist die Tage folgender Post unter die Augen gekommen, der sich mit der Produktivität befasst.

Die Kernbotschaft lautet: Trotz Milliardeninvestitionen in die KI-Infrastruktur zeigen sich die Produktivitätssteigerungen nicht in den Makrodaten. Ein Analyst von Forrester sagt dazu, dass "wir" in keiner der verfügbaren Statistiken einen KI-bedingten Aufschwung "sehen".

Bereits vor einigen Tagen bin ich zudem bei The Register auf den Artikel Experiment suggests AI chatbot would save insurance agents a whopping 3 minutes a day gestoßen. Forscher der Dakota State University haben in Zusammenarbeit mit dem regionalen Versicherungsunternehmen Safety Insurance einen experimentellen Chatbot namens „Axlerod" entwickelt, der unabhängige Versicherungsmakler unterstützen soll. Die Zeitersparnis lag gerade einmal bei 3 Minuten pro Tag. Gut, war ein Forschungsprojekt.

Die großen Einsparungen liegen doch beim Personal, wenn ich im Support Mitarbeiter sparen kann, schaufelt es die Kosten für die AI-Lösungen durch wieder rein? Auf Zeit Online ist die Tage der Beitrag "Was das schlimmste KI-Szenario wäre" (wegen Paywall nicht verlinkt) erschienen. Dort kamen Experten aus dem Bereich zu Wort. Katharina Zweig, Leiterin des Algorithm Accountability Labs am Fachbereich Informatik der TU Kaiserslautern, führt dort aus, was vermutlich viele aus der Leserschaft bereits erlebt haben. "Menschen trauen der KI zu viel zu und nutzen sie in Situationen, die Zuverlässigkeit verlangen, obwohl sie das nicht leisten oder garantieren kann."

Sprachmodelle und darauf basierenden KI-Agenten-Systeme können, laut Katharina Zweig, beispielsweise weder zuverlässig Kundengespräche führen noch Kundenwünsche ausführen. Ihre Prognose: Firmen werden viel Geld – und ihren guten Ruf – verlieren, wenn sie KI-Agenten verwenden, die am Ende nicht wirklich weiterhelfen können. Hier einige Zitate von Frau Zweig:

Ich habe selbst erlebt, wie KI wiederholt versuchte, meine Kundenbeschwerden entgegenzunehmen – und versagte. Das verärgert Kunden und kostet uns volkswirtschaftlich viel Zeit, die die Maschinen doch eigentlich einsparen sollen. Die Erfolge sind begrenzt, die Langzeitfolgen werden wir in anderthalb bis zwei Jahren sehen.

Als ich das las, war es wie ein deja-vue-Erlebnis, welches ich mit Bots im Beschwerde- oder Hilfemanagement vieler Firmen erlebt habe. Und kürzlich kamen mir hier einige Aussagen einer KI-Expertin unter die Augen, die ausführt, wofür sie diese Technologie keinesfalls verwenden würde. Kommt mir irgendwie bekannt vor, spiegelt es doch meine Gedanken wieder. Ich lese derzeit viel zu AI-Entwicklungen und experimentiere auch schon mal mit lokalen LLMs (RAG). Da gibt es sinnvolle Szenarien, die ich sehe, aber nicht das, was die AI-Protagonisten so zeichnen.

Aber es wird vom Marketing immer noch als "Stein der Weisen" angepriesen. Im Beitrag Verantwortungsvoller KI-Einsatz: Code of Conduct "Demokratische KI"; Governance und Abwägung gefordert hatte ich den Schweizer Anbieter Spitch angesprochen, der seinen Kunden verspricht, dass AI den Kundendialog übernimmt. Der Schuss kann auch nach hinten losgehen, war mein Folgerung, die in obigem Zitat bestätigt wurde.

Gerade trended eine Analyse der Beratungsgesellschaft PwC zum Nutzen von KI. PwC hat in einer weltweiten Umfrage unter Spitzenmanagern ermittelt, wie sich die KI auf deren Geschäft auswirkt und ob es messbare Produktivitätssteigerungen oder Kosteneinsparungen gibt. Zwischen 11 % (Deutschland) und 29% (international) der Befragten berichten von "höheren Umsätzen" zur KI (was immer das heißt). Global sind nur 12 % der Befragten in der Lage, Umsätze mit KI zu steigern oder Kosten zu senken – wobei man auch diese Zahlen hinterfragen könnte.

Insgesamt ergibt sich eine ernüchternde Bilanz. Ich verlinke mal den heise-Artikel Kaum Mehrwert in Firmen: Ist KI doch eine Enttäuschung?, der das Thema aktuell in deutscher Sprache aufbereitet. heise zitiert PwC-Deutschland-Chefin Petra Justenhoven mit folgender Aussage:

Die Ergebnisse zur KI-Adoption zeigen eine Diskrepanz zwischen hohen Erwartungen und einer ernüchternden Realität. Wir sehen eine große Bereitschaft, in KI zu investieren – aber nur eine kleine Minderheit von Unternehmen erzielt damit auch messbare Ergebnisse. Besonders rar ist noch die Fähigkeit, sich mithilfe von KI vom Wettbewerb zu differenzieren, neue Erlösquellen zu erschließen und dadurch zu wachsen.

Getroffen im 29. Global CEO Survey, für den PwC über 4400 CEOs aus 95 Ländern befragt hat. Nur zur Erinnerung: In diesem Bereich sind Milliarden-Summen (600 Milliarden US-Dollar) versenkt worden – das müsste irgendwann bezahlt werden. Das sieht gar nicht gut aus, wenn man nüchtern auf Aufwand und Ertrag blickt – die Berliner pflegen das unter "Außer Spesen nücht gewesen" zu verbuchen – aber die Spesenrechnung war schon arg happig, und die Controller in Banken und Unternehmen beginnen langsam zu streiken.

Mancher hofft, dass man da noch was mit "Schulung der Mitarbeiter" was machen kann, um die "Schätze mittels AI zu heben". Sind halt viele Traumtänzer unterwegs – war nicht das Versprechen der "künstlichen Intelligenz", dass die endlich den Leuten ermöglichen soll, "völlig unstrukturiert und ohne Fachwissen, ihre Fragen zu stellen und dann sinnvolle Antworten zu bekommen"? Und sollten nicht Bots Aufgaben übernehmen und alles selbständig abwickeln, die Leute kann man dann raus werfen?

Und jetzt soll man als einfacher Sachbearbeiter erst einmal auf "Prompt Engineer" promovieren, bevor man die richtigen Fragen an die LLMs stellen kann, so dass was Sinnvolles heraus kommt? Wobei die nächste Sau, die durchs Dorf gejagt wird, junge Leute davon abhält, sich überhaupt damit zu beschäftigen. Denn diese KI wird ja bald die "Wissensarbeiter" überflüssig machen, weil sie das alles ja besser kann. Junge Programmierer? Brauchen wir nicht, KI kann diese Aufgabe übernehmen. Redakteure, Anwälte, Analysten, kann KI alles viel besser.

The Register befasst sich hier mit einer Studie von Forrester, der auf die Auswirkungen von KI auf den Arbeitsmarkt eingeht. Es gibt Entlassungen, aber es ist kein Effekt auf die Wirtschaftlichkeit zu finden. Und es gibt einen Artikel, der sich damit befasst, wie KI die Institutionen in der Gesellschaft untergräbt und an den Wurzeln dessen rüttelt, was uns bisher definiert hat. Auf Substack gibt es den Artikel The AI revolution is here. Will the economy survive the transition?, der sich mit Fragen der Verwerfungen, die der AI-Hype ausgelöst hat und weiter auslöst, befasst.

So ganz naiv heruntergebrochen – es sind doch naheliegende Fragen, die sich ein junger Mensch heute möglicherweise stellt: Warum soll ich ein Studium oder eine Ausbildung in diesem Bereich beginnen, wenn ich später doch keine Arbeit bekomme? Nannte man früher "das Kind mit dem Bade ausschütten" – das wird uns in einigen Jahren noch mächtig auf die Füße fallen.

Fazit aus dem Abriss in diesem Abschnitt: Die blumigen Versprechungen der KI-Protagonisten in Bezug auf die Wirtschaftlichkeit oder Nützlichkeit haben sich bisher als Fata Morgana oder Täuschung erwiesen. Und ich sehe nicht, wie die Blase, die vom KI-Hype aufgebaut wurde, weiter tragen könnte – denn jetzt geht es ans Geld.

Ist OpenAI bald pleite?

Und damit sind wir beim letzten Thema dieses Artikels mit dem Abriss zur KI-Blase. Der "Musterknabe" des AI-Hypes ist die US-Firme OpenAI um Sam Altman. Die Firma wird zwar von Elon Musk auf über 100 Milliarden US-Dollar verklagt, weil Musk sich als früher Finanzier getäuscht sieht. Aber es gibt etwas viel brisanteres: Gab OpenAI mit seinen Entwicklungen die letzten Jahre den Takt der Branche an, verliert das Unternehmen seit kurzem Boden gegenüber Google und dessen Gemini-Modell.

Altmann hatte kürzlich in einem internen Memo Alarm geschlagen, dass 2026 das Jahr der Entscheidung für OpenAI werden könne, in dem sich herausstellt, ob die Firma überlebt. Eine aktuelle Meldung besagt, dass OpenAI auf ChatGPT Werbung schalten werde, so dass das Abonnement für 8 US Dollar pro Monat möglich werde (heise hat hier was zu veröffentlicht). Und in diesem heise-Artikel las ich zum Beispiel, dass OpenAI seine Rechenleistung gesteigert und den Umsatz auf 20 Milliarden US-Dollar verdreifacht habe – die typischen Erfolgsmeldungen, es gibt keine Grenzen, nur Rekord-Wachstum.

Die Finanzzahlen haben aber Leute bewogen, genauer hinzuschauen. Die Tage wurden daher Social-Media-Kanäle mit der brennenden Frage geflutet, ob OpenAI bald das Geld ausgeht und der Entwickler von ChatGPT bald pleite sei. Obiger Tweet bringt es mit dem leeren Geldbeutel und der Aussage, dass OpenAI heftig Geld verbrennt und alleine im Jahr 2026 die gigantische Summe von 14 Milliarden US-Dollar Verluste schreiben dürfte, auf den Punkt. Wenn es Sam Altman nicht gelingt, neue Geldgeber zu finden, könnte die Unternehmenskasse bereits im Jahr 2027 leer sein und die Pleite drohen.

Ein weiterer Post bringt es auf den Punkt: OpenAI schreibt [weiterhin] rote Zahlen und wird bei diesem Tempo bis 2027 kein Geld mehr haben, da es die Rentabilität von KI überschätzt hat. Jüngste Analysen und interne Prognosen deuten auf jährliche Verluste von rund 14 Milliarden US-Dollar im Jahr 2026 hin, nach etwa 8 Milliarden US-Dollar im Jahr 2025.

Der Poster führt diese Entwicklung auf eine Überschätzung der kurzfristigen Rentabilität zurück, da für OpenAI trotz starker Nutzerakzeptanz und Milliardenumsätzen weiterhin hohe Kosten für Inferenz und Rechenzentren anfallen. Ohne wiederholte massive Finanzierungsrunden könnte das Unternehmen laut Analysten bereits Mitte 2027 mit einem Liquiditätsengpass konfrontiert sein. Die Kollegen von Dr. Windows haben es in diesem Artikel ebenfalls aufgegriffen.

George Noble (Gründer eines Milliarden-Dollar-Hedgefonds und Fidelity Overseas Fund) wird hier so zitiert, dass OpenAI kurz vor dem Zusammenbruch steht. Die Zusammenfassung seiner Aussagen:

- Verlust von 12 Milliarden Dollar in einem einzigen Quartal.

- Rückläufige Besucherzahlen im zweiten Monat in Folge.

- Safeforce ersetzt ChatGPT durch Gemini und führende Entwickler kündigen.

- Elon Musks 134-Milliarden-Klage als Risiko und OpenAI benötigt 143 Milliarden, bevor es profitabel ist.

Die Aussagen: "Kein Start-up in der Geschichte hat jemals mit Verlusten in dieser Größenordnung operiert. Der AI-Hype-Zyklus erreicht seinen Höhepunkt. Die sinkenden Erträge lassen sich nicht mehr verbergen. Die Konkurrenz holt auf. Die Klagen häufen sich." Das Video ist in diesem Tweet eingebunden. Alles Anzeichen für einen Zusammenbruch – und dann stellt sich die Frage nach dem Kartenhaus, was andere Unternehmen in diesem Bereich mit reißt.

Meine zwei Cent

So faszinierend ich persönlich die Technologie hinter Large Language Modellen (LLMs) samt der Entwicklung sehe und auch dedizierte Einsatzszenarien, wo ein versuchsweiser Einsatz Sinn machen kann, erkenne, so ernüchtert bin ich seit Jahren bezüglich der Übertreibungen des Marketing und der KI-Protagonisten, die einen riesigen Hype befeuert haben. Wer nüchtern auf die Fakten geschaut hat, konnte bereits vor Jahren erkennen, dass sich da eine große Blase aufbaut, die irgendwann platzen muss.

Aber wie bei jeder Blase wurden Leute, die zur Vorsicht mahnten, als Spinner, Bremser und Bedenkenträger betitelt. Mir sind noch die Kommentare mit dem Beispiel der Dampfmaschine oder den ersten Zügen hier im Blog gegenwärtig. Wer nicht auf die Entwicklung aufspringe, werde zurück bleiben.

Die spannende Frage für mich ist, wann und wie die KI-Blase platzt, welche Verwerfungen dies auslöst und was am Ende des Tages dann übrig bleibt, und was sich sinnvoll verwerten lässt. Was aktuell aber bereits erkennbar ist, sind die Verwerfungen, die der Hype auf dem Arbeitsmarkt (an Unsicherheiten), bei Unternehmen (die mit hastig eingeführten AI-Lösungen gerade scheitern) sowie bei den Kosten für Speicher (dies wird einige Entwicklungen über die nächsten zwei, drei Jahre massiv ausbremsen) bereits ausgelöst haben.

Ähnliche Artikel:

Die KI-Blase wird platzen, aber wann?

Goldman Sachs warnt vor AI-Blase, die Rechenzenten-Boom platzen ließe

Der KI-Ressourcenverbrauch wird Stromnetze und Länder überfordern

KI-Sicherheit: Die spezielle Seite der neuen Technologie

Technische Hypotheken: Muss die KI-Revolution ausfallen? – Teil 2

Gesellschaftliche Risiken durch KI fürs Lernen – werden wir immer dümmer?

Job-Verluste durch KI – eine Themenübersicht

Private-Equity-Gesellschaft Apollo reduziert Unternehmensanteile wegen KI-Unsicherheiten

KI-Rechenzentren: Hardware-Wechsel verhindert Wirtschaftlichkeit

Gartner warnt: Blockt aus Sicherheitsgründen alle KI-Browser auf absehbare Zeit

ChatGPT: Atlas-Browser, der erste Schritt zum KI-Betriebssystem

Perplexity Comet Browser Prompt Injection als großes Sicherheitsrisiko

Sicherheit: AI-Browser und Copilot-Schwachstellen

No-Code Agentic AI kann für Finanzbetrug und Workflow Hijacking missbraucht werden

KI-Irrsinn Teil 1: Wenn ChaptGPT, Copilot & Co. dich zu Fake-Orten locken

KI-Irrsinn Teil 2: Amazon schickt Unterlassungserklärung an Perplexity AI für Einkäufe über Comet

KI-Irrsinn Teil 3: KI-generiere "Nichtigkeitsklage" vom Gericht abgewiesen

KI-Irrsinn Teil 4: Wenn die Anwender mal selber machen

KI-Irrsinn Teil 5: Deloitte, die KI und der versemmelte Report in Australien

KI-Irrsinn Teil 6: Autohändler gibt Kundendaten zum KI-Training an obskure Firma

Steuererklärung per KI? Expertin warnt vor Risiken

KI-Experiment gescheitert: Automat "verschenkt" Inhalte

Edge for Business und AI/Copilot im Browser: Böse Hörstörung bei Microsoft?

Vivaldi positioniert sich gegen KI-Agenten

MIT-Studie: "ChatGPT"- bzw. LLM-Nutzung und Gehirn-Aktivitäten

Job-Verluste durch KI – eine Themenübersicht

Gesellschaftliche Risiken durch KI fürs Lernen – werden wir immer dümmer?

MVP: 2013 – 2016

MVP: 2013 – 2016

Ich habe nichts hinzuzufügen, wollte bloß meinen Dank loswerden. An diesem hervorragenden Artikel sieht man einmal mehr, welche Qualität dein Blog hat. Macht bestimmt furchtbar viel Arbeit, aber der Gewinn für die Leser ist riesig.

Aus eigener Erfahrung mit ChatGPT kann ich sagen, der Nutzen im IT-Bereich ist ca. 50/50

entweder die Lösung zu einer Problemstellung ist wirklich hilfreich, oder nicht, oder es werden einfach komplett irgendwelche Menüpunkte herbeifantasiert. Das ist schon ein bisschen nervig. Aber die hilfreichen Fälle gleichen das bei mir aus, spart oft eben Zeit und Nerven.

Ich habe gerade spaßeshalber versucht, eine Aufgabe, von der ich keine Ahnung habe (eine bestehende, nicht-triviale, nicht von mir geschriebene Linux-Software auf Windows zum Laufen zu bringen) mit Hilfe der Gratis-Version von ChatGPT zu bearbeiten.

Die Erfahrung war durchmischt: In etwa einem Drittel der Probleme war die Hilfe von ChatGPT „spot on"; bei einem Drittel war sie nicht direkt brauchbar, hat mich aber auf den richtigen Weg gebracht; beim letzten Drittel waren die Vorschläge total daneben.

Letztlich habe ich so das Compilieren und Deployment hinbekommen. Aber war das nun effizienter als der traditionelle Weg? Schwer zu sagen. Vielleicht, aber wenn, dann wohl nicht viel.

Kann ich auch nur beipflichten.

Dampfmaschine nehem ich auch gerne als Vergleich. =)

Hauptproblem der KI-Technik sehe ich so: Du brauchst einen Spezi um das Ergebnis zu prüfen, den Spezi erhälst Du aber nicht, wenn der Lehrling seine Arbeit nicht von der Pike her lernen musste.

So ähnlich ist das auch mit den Ingenieuren, sie studieren direkt nach der Schule statt erstmal in der Praxis Erfahrungen zu sammeln. Sprich es studieren nicht unbedingt die "richtigen". Auf lange Sicht wird das nicht funktionieren.

Ich sehe das als ganz normalen Lebenszyklus einer neuen Technologie. Nach einer Phase der Euphorie setzt ein Realitätscheck ein und es kristallisieren sich die Anwendungen heraus, in denen sich wirklich ein greifbarer Nutzen ergibt.

Die älteren werden sich vermutlich noch an das Zeitalter der beginnenden Raumfahrt erinnern. Es gab eine Sturm-und-Drang-Phase in den 60ern, in der praktisch alles möglich schien. Nachdem mit der Mondlandung alle erreichbaren Ziele "abgegrast" waren, setzte eine große Ernüchterung ein.

Trotzdem möchte ich heute nicht in einer Welt leben ohne Satelliten, die die Erde umkreisen und von Kommunikation bis Wettervorhersage allerlei greifbaren Nutzen bringen.

Oder Robotern, die zwar ihr in den 80ern postuliertes humanoides Antlitz größtenteils verloren haben, ohne die aber eine Industrieproduktion heute kaum noch denkbar wäre.

Für die oben postulierten Probleme werden sich mit der Zeit Lösungen finden. Rechenzentren werden in Zukunft modularer und standardisierter sein.

Da wird kein Elektriker mehr Steckdosen neben einem Rack an die Wand schrauben, sondern es gibt skalierbare Systeme, bei denen man einfach ein weiteres Modul mit allen benötigten Anschlüssen auch für Daten, Kühlung und Strom anflanscht. Die Innenverkabelung eines PC sieht heute auch nicht mehr so aus wie vor 30 Jahren, insbesondere die vielen händisch zu montierenden Stromkabel mit Molex-Stecker und die Flachbandkabel sind praktisch weggefallen.

Wie so etwas laufen kann hat Google vor und 20 Jahren (als sie ihre großen Suchmaschinenstandorte ausrollten) mal in einem Video gezeigt, alles in Containern, billig und auf das nötigste reduziert mit Open-Frame-Mainboards statt schicker Rack-Gehäuse, aber einfach wartbar und schnell in größerem Maßstab ausrollbar.

Für das Energieproblem gibt es auch schon die Idee, Kernkraft zu nutzen, die (wenn man alle Folgekosten und Risiken ausblendet) sehr preiswert und sogar CO2-neutral ist. Man darf nicht vergessen, daß die Supermächte seit Jahrzehnten Flugzeugträger und U-Boote damit ausstatten ohne daß es regelmäßig zu großen Unfällen kommt.

Letztendlich wird der greifbare Nutzen darüber entscheiden. Da kenne ich ganz andere Aussagen als im Einleitungssatz, meinen Kollegen bringt KI inzwischen sehr wohl Vorteile im betrieblichen Einsatz, sei es beim textlichen Zusammenfassen eines längeren Meetings oder Schriftwechsels oder auch bei routinemäßigen Programmieraufgaben. Ein Kollege sagte mir neulich mal, daß ihm ChatGPT in Fünf Minuten eine funktionsfähige Lösung präsentiert hat für eine Aufgabe, die er selbst vor zehn Jahren in über einer Woche implementiert hat.

Zusätzlich ermöglicht es uns KI, Dinge zu tun, die wir sonst vermutlich nicht getan hätten, im Kontext dieses Forums beispielsweise ein SIEM, also ein System, welches kontinuierlich Log-Dateien durchliest und auf auffällige Muster und Korrelationen schaut. Jeder, der selbst mal in Logdateien nach Fehlern gesucht hat weiß wie nervtötend es sein kann, in immer wieder gleichen Zeilen die eine relevante Abweichung zu finden – nichts was man freiwillig und zum Zeitvertreib tut.

Ich bin nun ja schon etwas älter – ich erinnere mich nicht, dass die von dir genannten Entwicklungen wie Raumfahrt, Roboter etc. jemals diese gigantischen Kapitalsummen gebunden und die Ökonomie "scheinbar" am Leben gehalten – und diesen gesellschaftlichen Impakt (wie jetzt die KI) gehabt haben. Und bezüglich deiner Kernkraft-Argumente: Flugzeugträger und U-Boote sind Militär, wo Kosten keine Rolle spielen. Zudem ist deren Zahl arg begrenzt – für den Einsatz von Atomkraft zum Tragen des KI-Energiehungers müssten wir in gänzlich andere Größenordnungen skalieren. Da reden wir von Rohstoffen, Herstellkapazitäten, Know-How zum Aufbau, zum Betrieb, zur Wartung etc. und von Kosten. Alles endliche Ressourcen. Mein Ingenieurstudium, wo ich mit Kerntechnikern in den gleichen Vorlesungen zusammen saß, ist schon arg lange her. Aber die Physik und Werkstofftechnik, die uns damals bereits Kopfschmerzen bereitete, gilt (neben der Ressourcen-Frage) m.W. auch noch heute – auch wenn das gerne auf schönen PowerPoint-Folien weggezaubert wird.

Es gibt eine alte Erfahrung: Immer, wenn ich mir dann mal bestimmte Fragen stelle (z.B. Wasserstoffversprödung in Stählen, Abrasion von Komponenten durch geschmolzenes Salz in den SMRs) stoße ich in neueren Papers auf Aussagen, die mir irgendwie bekannt erscheinen. Aber es mag sein, dass ich an den falschen Stellen schaue – und ich bin auch da nicht mehr in der Technik drin. Aber als Ingenieur stelle ich mir dann schon bestimmte Fragen, die so auf PowerPoint-Folien für Investoren oder die Presse eher nicht auftauchen (könnte Leute verwirren).

Wo ich bei dir bin: Ja, das Beispiel für das SIEM mit der log-Auswertung teile ich – und es gibt eine breite Palette von möglichen Einsatzszenarien für LLMs. Daher befasse ich mich ja mit dem Thema und lese viel. Aber mir ist immer das Beispiel aus der Astronomie vor Augen, wo Sternenkataloge durch KI durchforstet wurden. Und dann kommt jemand und hinterfragt die Modelle, passt deren Parameter kräftig an und findet gänzlich neue Objekte in diesen Aufnahmen. Dafür war die vorherige KI-Lösung schlicht blind – und nun übertrage das mal auf dein Beispiel des SIEM.

"Mann, sind wir stolz, wie unsere SIEM uns in Sicherheit wiegt", aber können wir uns sicher sein, dass die bösen Buben nicht längst im System sind? Es ist immer die Gretchenfrage: Kann ich eine Entscheidung auf eine KI-Aussage bauen, wo diese isoliert halbwegs richtig sein muss? Dann lautet die Antwort: Ja. Wenn es aber heißt: Die Entscheidung kann ich nur treffen, wenn alle Aspekte zu 100 % erfasst und korrekt vorgelegt vorgelegt wurden, müsste man das irgendwie doch mal überdenken. Meiner Beobachtung nach ist das letztgenannte Szenario aber das, was verkauft und von den Leute auch geglaubt wird.

> "Man darf nicht vergessen, daß die Supermächte seit Jahrzehnten Flugzeugträger und U-Boote damit ausstatten ohne daß es regelmäßig zu großen Unfällen kommt."

Da möchte ich kontern, dass es bei Militärausgaben grundsätzlich keine Kosten-Nutzen-Abwägung gibt. Die können sich das schlicht leisten.

Auch sind deren Reaktoren deutlich kleiner.

Und außerdem unterliegt dort alles eh der Geheimhaltung.

Mit anderen Worten, wenig vergleichbar.

"Für das Energieproblem gibt es auch schon die Idee, Kernkraft zu nutzen, die (wenn man alle Folgekosten und Risiken ausblendet) sehr preiswert und sogar CO2-neutral ist."

Das trifft nur auf bestehende Anlagen zu, nicht auf Neubauten. Das ist auch der Grund warum China sein Nuklearpark auf 5% begrenzt. Ich weiß nicht wie oft man das noch betonen muss.

EE + Speicher ist die Zukunft oder irgendwann vielleicht Fusionskraftwerke.

Ne Kernkraft ist super, so lange es nicht in Erdbeben Gebieten stattfindet. Heutige Kernkraftwerke sind um ein vielfaches sicherer als Tschernobyl. Bis wir zur Fusionsenergie kommen sollte das reichen.

Nach dem Platzen der KI-Blase wird dasselbe passieren wie nach der Sub-Prime-Hypothekenkrise 2008/09:

die produktive Wirtschaft (Produkte und Dienstleistungen, für die Geld auszugeben Konsumenten und Firmen gewillt sind) und die Konsumenten selbst werden die Kosten tragen in Form schlechteren Wachstums, schwächelnden Arbeitsmärkten, höherer Inflations- und Steuerbelastung.

Nur die Verursacher wird es nicht treffen: die haben sich ihre Boni schon auszahlen lassen und ihre Aktienpakete schon zu Geld gemacht.

gefühlt der 100. Artikel mit dem in diesem Blog die offensichtliche Ablehnung von KI neben der Ablehnung von Windows ausgedrückt wird, denn es wird ja jede mögliche Quelle und Gelegenheit dafür aufgegriffen. Legitim, aber irgendwann langweilig, zumal dann ja auch immer wieder die gleichen Kommentare kommen, in der ähnlich denkende sich halt selbst bestätigen, was dann natürlich den Eindruck verstärkt, dass dies ja so sein wird, was da so geschrieben wird.

Schauen wir einfach mal, ob zum Beispiel OpenAI in einigen Monaten sein pleite wird.

Das hier ist nicht irgendein Meinungsblog, sondern vornehmlich ein News-Aggregator.

Und zu genau dem Zweck schreibt Günther diese Beiträge und lesen diese.

Ich zumindest gerne.

ich lese sie auch :) Trotzdem wird natürlich eine Meinung gepusht. Und wie ich sagte, das ist absolut legitim. Man sollte es aber auch einordnen…

Ich formuliere es mal so: Natürlich ist Meinung dabei (und es spiegelt das wieder, womit ich momentan auch medial in jeder Presseschau erschlagen werde) – aber ich bin jetzt vom Kommentar a bisserl enttäuscht. Die Texte enthalten ja Fragen, die gestellt werden und Antworten harren. Mir fehlen Antworten dergestalt: Born, da liegen alle deine Annahmen falsch. Alles, was ich so höre: Kernkraft wird es richten; wir machen einfach mal, oder "aber da und da hat AI mir was gebracht".

Ich weiß ja nicht, was jetzt für mich schlimmer ist: Wenn ich Recht habe, und die KI-Blase platzt und wir die Scherben aufkehren müssen. Oder wenn ich Unrecht habe und wir in für Jahren in der gerade gezeichneten "goldenen KI-Zeit" leben, wo Du noch nicht mal denken musst, aber beim Arbeitsamt in der Schlange stehst.

Im Übrigen: Ein wenig am Rande befasse ich mich schon (abseits der Bemühungen, alles, was mir zwangsweise als AI auf Android und Windows gespült wird zu deaktivieren) mit der Frage, wo LLMs in anderer Umsetzung (z.B. als RAG, Retrieval Augmented Generation) lokal für irgendwelche Zecke eingesetzt werden können. Bin aber noch nicht allzu weit mit gekommen (muss mir mal anschauen, ob bestimmte lokale LLMs vernünftig unter Linux laufen). So erste Ideen, die ich mir vorstellen könnte, habe ich aber irgendwie noch nicht zusammen stricken können.

>> aber beim Arbeitsamt in der Schlange stehst

Ich (studierter Informatiker) empfehle jungen Leuten in meinem Umfeld schon seit langem und nicht erst seit dem KI-Hype, *nicht* zu studieren, sondern einen handwerklichen Beruf zu ergreifen.

Es ist heute selbst bei Aufträgen in fünfstelliger Größenordnung schon schwierig, überhaupt Angebote zu bekommen, und absehbar, dass Handwerker in nicht allzu ferner Zukunft ihre Dienstleistungen mal an den Meistbietenden versteigern werden.

Den ganzen Psychologie- und Wirtschaftswissenschaft-Studenten bleibt dann nur, Taxi zu fahren. Ach nee, Taxis gibt's dann ja auch nicht mehr…

Erinnert mich ein kleines bisschen an https://borncity.com/blog/2017/10/29/sonntags-tipp-virales-spiel-paperclips/ – habs durchgespielt, irgendwann war keine Materie mehr da.

Ich versteh nicht WIE und WARUM man etwas macht. Ich hab teilweise den Eindruck, dass da Niemand ansatzweise nachdenkt. Ich hab den Gefühl die wissen selber nicht wohin.. Ich weiß nicht mal, ob die großen Unternehmen wirklich mal geziehl die Bereiche bewerben wo die KI wirklich erhebliche Vorteile bringt.

Google ballert dir irgendwelche KI-Antworten hin, es gibt einige Leute die ignorieren das komplett. Du kannst es ja nicht mal einfach abschalten. Angeblich braucht die KI-Antwort ja auch deutlich mehr Energie als die normale Suche. Wenn es Leute abschalten die es nicht nutzen, wäre das eigentlich ein Vorteil. Auch weil dann die Kritiker nicht mal damit belästigt werden.

Ich versteh auch nicht wo dann die Einkünfte herkommen sollen. Du kannst zwar in den KI-Antworten geziehlt bezahlte Werbung und Quellen einfügen. Mal von diversen Kennzeichnungspflichten bagesehen, die gar nicht mal so einfach umsetzbar sind, es belastet dann die Qualität der Antworten.

KI verdient kein Geld ist die Aussage, ob KI Geld einspart oder Vorgänge optimiert steht auf einem anderen Blatt.

KI kann unterstützen eingesetzt werden, aber es muss am Ende immer noch ein Mensch dahinter sitzen der alles verifiziert.

KI kann aus einer einfachen Powershellabfrage ein GUI basiertes Tool bauen, mit diversen Funktionen und Möglichkeiten. KI kann sich aber auch bei Fehlern in einer Endlosschleife verheddern, wo die Lösung von Problem A zu Problem B führt, was dann die KI wieder mit Lösung A lösen will, was wieder zu Problem A führt, usw.

Wenn man der KI dann nicht ein alternativen Lösungsweg vorschlägt, kommt sie da nicht mehr raus.

Das ist das Problem der KI.

Dazu passt der Spruch: Man kann Probleme nicht mit der gleichen Denkweise lösen durch die sie entstanden sind!

Aber genau das: Gleiche Denkweise bei der Problemlösung wie bei der Problemgenerierung macht KI.

Und daher kann eine KI auch kaum Probleme, die sie selbst verursacht hat, lösen.

Hoffentlich. Dann entspannt sich der Hardwaremarkt endlich wieder.

LLM ≠= K(A).I.

Bis dahin braucht es noch eine Weile (werden wir und unsere folgende ?Generation?) nicht mehr erleben!?!

Lest "Träumen Androiden von elektrischen Schafen" oder schaut Euch Filme wie "Blade Runner (1982)" oder auch "Ex Machina (2015)" und/oder "The Creator (2023)" an – in allen wird ansatzweise "echte K(A).I." beschrieben.

Ich stehe in einem Geschäft und prüfe, ob die Universalbedienung X für mein Gerät Y geeignet ist.

1. Ich suche konventionell und lese im Geschäft durch x Seiten…

2. Ich mache ein Foto, sende es Gemini und lasse ihn mir in wenigen Sekunden eine Antwort liefern…

Frage: was macht mehr Spaß? Gibt es einen konkreten Nutzen?

Sicherlich 2.

Klar, muss man trotzdem nicht zwingend haben, trotzdem ist der klare Nutzen erkennbar.

Ist nur ein kleines harmloses, aber reales, Beispiel aus dem eher privaten Bereich, im geschäftlichen Bereich würde man ganz andere Szenarien finden, auch aus meiner ganz persönlichen Erfahrung, die einen klaren Nutzen zeigen.

Ich komme von einer Autofahrt wieder, mein Kilometerzähler zeigt unmögliche Werte an. Ich befragte am Handy Google, was das sein könne. Die KI-Antwort lautete "das Teil ist kaputt, fahr zur Werkstatt und lasse es dir austauschen". Glücklicherweise kam mir am Abend der Gedanke: "Schau nochmals, bevor Du morgen zur Werkstatt fährst", und ich habe die KI-Zusammenfassungen ignoriert. In zwei Foren fand ich ähnliche Aussagen und die Aussage, das "umzustellen". Nach dreifacher Recherche und mehrfachem Blick ins Bordhandbuch habe ich dann den Schalter gefunden, wo das umgestellt wird. War dann der Kipppunkt, wo ich beschlossen habe, keiner KI-Zusammenfassung mehr zu vertrauen, wenn ich das nicht ganz fix verifizieren kann.

Und damit sind wir wieder beim Kernpunkt – Ja, ich kann mir durch LLMs einige Aussagen zusammen stellen lassen. Aber ist es mir es dann wert, 20 US $ pro Monat zu zahlen, um "Spaß zu haben" oder Aussagen zu bekommen, die dann doch nichts taugen? Ich rede nicht davon, das Greti und Plethi irgendwelche Fun-Erlebnisse haben, sondern hinterfrage: Kann die Entwicklung, die gerade sichtbar ist und für die nächsten Jahre skizziert wird, tragen?

Grundsätzlich sollten mehrere KIs befragt werden um ein brauchbares Ergebnis zu erhalten. Der Markt wird sich ausdünnen aber ganz sicher werden sich die besten Modell durchsetzten. Im IT Sicherheitsbereich ist AI/KI mittlerweile elementar. Ebenso im modernen KFZ um Objekterkennungen durchführen zu können.

3.

Ich gehe auf die Herstellerhomepage und lade die Bedienungsanleitung herunter und lese die durch.

Denn da steht immer mehr drin als Gemini als Antwort weiß.

Und Gemini ist auch oft fehlerhaft.

Erfahrung 1:

Ich suche nach etwas, Gemini behauptet, das es das Ding nicht gibt.

Die normale Google-Sucher liefert aber jede Menge Treffer

Erfahrung 2:

Ich suche nach etwas, für das es genau 5 richtige Antworten gibt und frage explizit nach ALLEN richtigen Antworten.

Gemini (und auch ChatGPT und andere KIs) kennen aber nur 2-3 Antworten.

Was will ich mit solchen Ergebnissen?

Insbesondere Gemini kennt nicht einmal die Ergebnisse der Standard-Gogle-Suche?

Was ist das für ein System, das nicht einmal hausinterne Dienste richtig nutzen kann?

Was gab es in dem konkreten Fall für ein konkretes Ergebnis?

Das sind gerade die Fälle wo die KI bei mir nahezu immer halluziniert. Die KI spuckt immer eine Antwort aus, aber wie ist diese begründet? Was was die KI ausspuckt mag am Ende nicht "falsch" sein, aber es ist halt oft "guesswork". Bei konkreten Quellen und Antworten wird es dann schwach.

Bei Produkbezeichnungen kommt die KI durchaus durcheinander, insb. wen nes da mehrere Varianten gibt. Handbücher die man leicht findet findet auch die KI (meist…), ansonsten findet die KI auch hier oft nichts.

Wobei ich hier auch Niemanden raten würde die KI auf Handbücher zu nehmen, auch wenn die KI hier in dne Handbüchern was findet. Man lernt ja auch was indem man die Dinger durchliest…

Ziemlich genau das Szenario, das ich kürzlich erlebt habe. Nur dass ich

1. selbständig die Bedienungsanleitung vom Hersteller runtergeladen und durchgelesen habe. Dort wurde erklärt, wie man den Timer programmiert, aber nicht, wie viele Speicherplätze er hat.

2. Daher habe ich die KI danach gefragt. (Als des Lesens und Schreibens noch Kundiger habe ich allerdings kein Foto des Geräts hochgeladen, sondern die Modellbezeichnung in meiner Frage erwähnt – ich glaube nicht, dass das Schuld am folgenden hat.)

• Antwort der KI: 42. Das Gerät bietet 42 Speicherplätze. Steht so in der Bedienungsanleitung des Herstellers.

• Meine Gegenfrage: Wo? Ich finde dort nirgends eine Angabe.

• Antwort der KI: Ach ja, da habe ich mich offensichtlich getäuscht, tschuldigung. Dann weiß ich's auch nicht. Frag doch am besten beim Hersteller-Support an.

Was also hat mir die KI gebracht? Vertane Zeit und eine Fehlanschaffung, wenn ich ihr die unplausible Zahl abgenommen hätte.

Meine wiederholte Erfahrung ist: KI-Antworten sind dermaßen unzuverlässig, dass man ihnen generell nicht trauen kann. Niemals etwas unhinterfragt akzeptieren, oft stellt schon einmaliges Nachhaken die KI bloß.

Wenn lt. diversen Umfragen derzeit 93% der User keine AI möchten und die ganzen Unternehmen trotzdem den Usern und anderen Unternehmen alles an AI unterschieben wollen was geht, hoffe ich sehr, dass es bald platzt, kann man wirklich nur hoffen.

Ich bin lediglich der Meinung dass KI in Bereichen Medizin, Forschung und generell wissenschaftlichen Forschungen gerne unterstützen kann, da macht manches Sinn. Aber für den "Normalverbraucher" und den normalen Unternehmen…… k.K.

Gerade in der Forschung wäre ich misstrauisch. Dafür halluziniert die KI zu viel. Mir fällt da eine Bildbearbeitungssoftware ein, die – jetzt mit KI – Fotos großzoomt. Schon an den Beispielfotos konnte ich erkennen, was da gemogelt wird: Dass das Gesicht beim Vergrößern porenfrei geschönt wurde, sieht jeder auf Anhieb. Aber dass bei der Blume der Farbübergang in den Blütenorganen frei erfunden war, merkt nur jemand, der sich mit Botanik gut auskennt.

Nun stelle man sich mal vor, wenn die KI Röntgenbilder „aufbereitet", um allerlei Artefakte bereichert und daraus dann eine Diagnose abgeleitet wird. Es kommt jetzt schon vor, dass die rasant weiterentwickelte Technik Detailinformationen liefert, von denen selbst Fachärzte nicht wissen, ob sie überhaupt eine medizinische Bedeutung haben. Wenn dann noch die KI ihren Senf dazugibt, gute Nacht.

Würd mir sehr wünschen dass diese Phase bald vorbei ist (Kosten/Nutzen sehr schlecht), denke aber das Problem ist dass Konzerne/Investoren zu viel "cash on hand" haben und nicht wissen, wohin damit. Die spielen sich ja das Geld gegenseitig zu.

Frage mich auch, wie sehr die Speicherkosten in der Praxis zu Buche schlagen, denn da könnte es langfristige Verträge (wir kriegen den und den RAM für so viel Dollar) geben.

Denke es wird leider noch ein paar Jahre dauern, sofern nichts anderes die Börsen durcheinander bringt. ZB Handelskrieg oder eine chinesische Blockade von Taiwan.

Wäre natürlich geschickt, wenn die EU gezielt die KI-Hütchenspieler ins Visier nehmen würde, falls die Spannungen mit den USA sich verschärfen; irgendwie glaube ich es nicht.

AI oder das was heute als AI bezeichnet wird, wird sicher nicht verschwinden. Aber gesellschaftlich müssen wir uns fragen: Wenn ich alle Leute in der Wertschöpfungskette entlasse, und niemand mehr Geld verdient, wer ist dann noch da um meine Produkte zu kaufen?

Bezgl. Strom ist eher die Idee auf miniaturisierte Kernkraftwerke zu setzen, wie sie zB X-Energy liefert.

Ironie ist, wenn Analysten — also exakt die, deren Arbeit die KI wahrscheinlich effizienter/schneller/billiger erledigen kann — den Einsatz von KI empfehlen und als dringend geboten ansehen.

Kollegen, die KI getestet haben, haben festgestellt, dass man nur dann überwiegend brauchbare Ergebnisse erhält, wenn man die Frage-/Aufgabenstellung wirklich exakt zuschneidet und genau definierte Parameter und Daten übergibt. Der Aufwand ist mitunter so groß, dass man die Arbeit dann auch gleich selber erledigen kann, immerhin spart man sich so einen Großteil der Zeit, der in die anschließende Überprüfung der KI-Ergebnisse geflossen wäre.

Angesichts der Lage des Planeten könnte man die Ressourcen besser verwenden.

Wir steuern die Titanic mit Volldampf sehenden Auges direkt auf den Eisberg.

solche Aussagen sind wie immer sehr relativ und subjektiv.