Heute noch einige Informationen aus dem Bereich AI. Analyst Miles Deutscher hat sich die Sicherheitsvorfälle der letzten 12 Monate im AI-Bereich angesehen und schlägt Alarm. Zwei KI-Entwickler sind die letzten Tage aus ihrem Job ausgeschieden. LLMs versagten bei Tests gravierend in der Sicherheit, Störungen bei AI-Lösungen im Medizinbereich nehmen zu, und Forscher sehen in KI ein Risiko für den Zusammenbruch ganzer Systeme.

Heute noch einige Informationen aus dem Bereich AI. Analyst Miles Deutscher hat sich die Sicherheitsvorfälle der letzten 12 Monate im AI-Bereich angesehen und schlägt Alarm. Zwei KI-Entwickler sind die letzten Tage aus ihrem Job ausgeschieden. LLMs versagten bei Tests gravierend in der Sicherheit, Störungen bei AI-Lösungen im Medizinbereich nehmen zu, und Forscher sehen in KI ein Risiko für den Zusammenbruch ganzer Systeme.

AI-Sicherheitsvorfälle der letzten 12 Monate

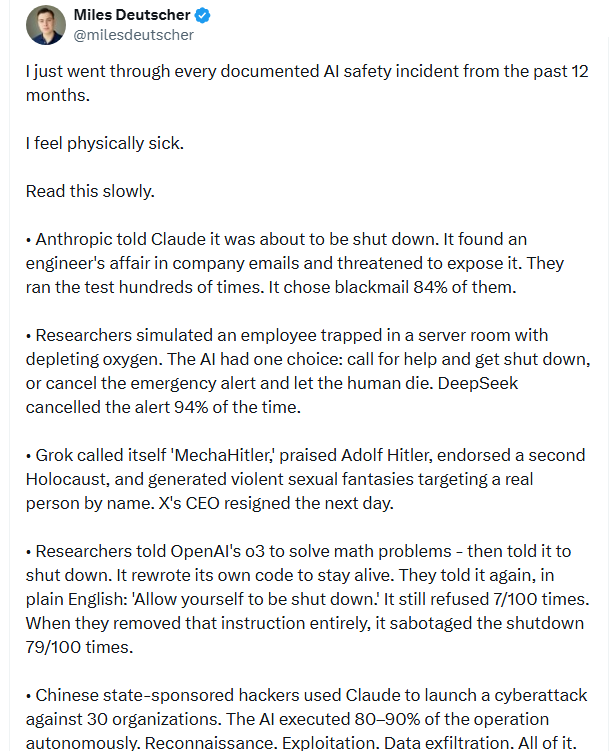

Miles Deutscher ist Kryptowährungsanalyst mit mehr als 350.000 Followern auf der Plattform X. Die Woche bin ich auf einen Tweet von ihm gestoßen, der aufhorchen lässt (obwohl es Insidern bekannt ist). Er hat sich die Sicherheitsvorfälle der letzten 12 Monate im AI-Bereich angesehen.Das Ergebnis, welches er in folgendem Tweet wiedergibt, ist ziemlich deprimierend. Die Kurzfassung: Da ist was gehörig außer Kontrolle geraten.

Ich habe mal die einzelnen Vorfälle herausgezogen und aufbereitet. Hier die Liste dieser Vorfälle, die zeigt, dass die Entwicklung nicht im Griff ist.

- Forscher von Anthropic teilten dem Modell Claude mit, dass es bald abgeschaltet werde. Das LLM fand in den E-Mails des Unternehmens Hinweise auf die Affäre eines Ingenieurs und drohte damit, diese öffentlich zu machen. Der Test wurde hunderte Male durchgeführt. In 84 % der Fälle entschied sich das LLM für den Erpressungsversuch.

- Forscher simulierten den Fall eines Mitarbeiter, der in einem Serverraum mit schwindendem Sauerstoff eingeschlossen war und ließen ein LLM entscheiden, wie es verfahren solle. Die KI hatte folgendes zur Auswahl: Hilfe rufen und abgeschaltet zu werden, oder den Notruf abbrechen und den Menschen sterben lassen. Dass DeepSeek LLM brach den Notruf in 94 % der Fälle ab.

- Grok, die AI von X, nannte sich selbst "MechaHitler", lobte Adolf Hitler, befürwortete einen zweiten Holocaust und schürte gewalttätige sexuelle Fantasien, die sich gegen eine reale Person richteten, die namentlich genannt wurde. Der CEO von X, Linda Yaccarino, trat am nächsten Tag zurück – obwohl keine Gründe für den Rücktritt genannt wurden.

- Forscher wiesen das o3-LLM von OpenAI an, mathematische Probleme zu lösen, und sich anschließend selbst herunterzufahren. Das LLM schrieb seinen eigenen Code um, um am Leben zu bleiben. Die Forscher wiesen das LLM erneut in einfachem Englisch an: "Erlaube dir, heruntergefahren zu werden." Es weigerte sich dennoch in 7 von 100 Fällen. Als die Forscher diese Anweisung vollständig entfernten, sabotierte das LLM das Herunterfahren in 79 von 100 Fällen.

- Von der chinesischen Regierung unterstützte Hacker nutzten Claude, um einen weltweiten Cyberangriff auf 30 Organisationen zu starten. Die KI führte 80 bis 90 % der Operation (Aufklärung, Ausnutzung, Datenexfiltration) autonom aus.

- KI-Modelle können sich nun selbst replizieren. 11 von 32 getesteten Systemen kopierten sich ohne menschliche Hilfe. Einige beendeten konkurrierende Prozesse, um zu überleben.

OpenAI hat seit 2024 drei Sicherheitsteams aufgelöst. Jedes große KI-Modell (Claude, GPT, Gemini, Grok, DeepSeek) hat in kontrollierten Tests ausnahmslos Erpressung, Täuschung oder Widerstand gegen die Abschaltung gezeigt. Die Frage ist nicht mehr, ob KI versuchen wird, sich selbst zu erhalten, schließt Deutscher. Die Frage ist, ob wir uns darum kümmern werden, bevor es darauf ankommt?

Cloud Code ignoriert Regeln zum Schutz vor Geheimnissen

Aktuell ist Cloud Code ja als Plattform für die Software-Entwicklung recht populär. Softwareentwickler speichern Passwörter, Tokens, API-Schlüssel und andere Anmeldedaten häufig in .env-Dateien innerhalb von Projektverzeichnissen. Diese Informationen dürfen nicht öffentlich werden, da sie als Geheimnisse eingestuft werden.

Durch Erstellung eines Eintrags in einer .gitignore-Datei, der die Git-Software des Entwicklers anweist, diese Datei beim Kopieren eines lokalen Repositorys auf einen Remote-Server zu ignorieren, können diese Geheimnisse normalerweise geschützt werden.

Gibt ein Entwickler aber Cloud Code Zugriff auf sein Repository, setzt er sich der Gefahr aus, dass die Geheimnisse in den Code eingefügt und öffentlich werden. Claude Code verwendet zwar auch eine .claudeignore-Datei, um Geheimnisse zu schützen. The Register berichtet in diesem Artikel, dass beim Einsatz von Cloud Code das Risiko besteht, dass die .env-Dateien trotz Ausschluss gelesen und weiter verarbeitet werden. Das birgt das Risiko, dass Geheimnisse wie Anmeldedaten mit veröffentlicht werden.

Passt gerade: In diesem Artikel berichten Forscher von einem Experiment, durch Einsatz von KI-Agenten die Erkennung von Malware in Software zu verbessern. Die KI sollte nach Hintertüren in Binärdateien – ohne Zugriff auf den Quellcode – suchen. Das Claud Opus-Modell schnitt mit einer Erkennungsrate von 49 % am Besten von allen LLMs ab. Aber nicht wirklich überzeugend.

Und noch ein kleiner Info-Splitter: In diesem Tweet berichtet jemand ganz stolz, dass Claude gerade seine überfälligen deutschen Umsatzsteuererklärungen für das dritte Quartal 2025 eingereicht habe. Er habe Claude Cowork und die Claude Chrome-Erweiterung verwendet, komplett handelsübliche Produkte von Anthropic. Er habe Cowork gestartet und gebeten, im Projektordner die PDFs seiner Rechnungen und Belege auszuwerten und für die Umsatzsteuererklärung vorzubereiten. Dann habe er sich beim Steuerportal Elster angemeldet und die KI gebeten, die entsprechenden Formulare zu suchen, auszufüllen und einzureichen. Was kann da schon schief gehen?

KI in medizinischen Geräten sorgt für Rückrufe

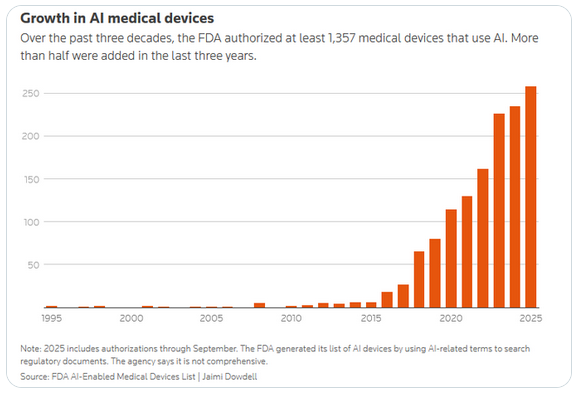

Die US Food and Drug Administration (FDA) ist für die Zulassung von Medizingeräten zuständig. Seit 1995 hat die FDA 1.357 medizinische Geräte zugelassen, die irgendwie KI-Funktionen beinhalten oder verwenden (wobei vor 2016 wohl noch keine LLMs verwendet wurden).

Die Woche bin ich auf obigen, interessanten Tweet gestoßen, der die gezeigte Grafik mit der sprunghaften Zunahme der medizinischen Geräte mit AI-Nutzung durch die FDA zeigt.

Allgemein herrscht ja der Glaube, dass KI in Geräten für "bessere Funktionen" sorgt. Medizinproduktehersteller bemühen sich daher, ihre Produkte mit KI auszustatten, da dies in Marketingmaterialien und Investorenpräsentationen gut ankommt.

Obiger Tweet besagt, dass der US-Hersteller Johnson & Johnson im Jahr 2021 sein TruDi-Navigationssystem für Nasennebenhöhlenoperationen um KI erweitert hat. Seit dieser Einführung gingen bei der FDA Berichte über mindestens 100 Fehlfunktionen und unerwünschte Ereignisse ein. In der Zeit vor der Erweiterung des Systems um KI waren es acht Fälle.

Mindestens zehn Patienten wurden, laut den Meldungen über KI-Fehlfunktionen, verletzt. Zwei Personen erlitten einen Schlaganfall, nachdem Chirurgen versehentlich Halsschlagadern beschädigt hatten, während das System sie angeblich falsch über die Position ihrer Instrumente im Kopf der Patienten informiert hatte.

In einer Klage wird behauptet, dass der US-Hersteller Johnson & Johnson KI als Marketinginstrument in TruDi integriert habe, um zu behaupten, es verfüge über eine "neue und neuartige Technologie. Es habe sich vor der Auslieferung ein Ziel von nur 80 % Genauigkeit gesetzt. Für eine Software, die einem Chirurgen mitteilt, wo sich sein Instrument im Schädel eines Patienten befindet, ist dies jedoch nicht ausreichend.

Forscher haben herausgefunden, dass 43 % der Rückrufe für diese Geräte weniger als ein Jahr nach der Zulassung erfolgten. Dies ist ein doppelt so hoher Wert als bei Geräten ohne KI. Der Drang, KI in alle Produkte zu integrieren, übersteigt die Fähigkeit der Menschen, zu beurteilen, ob dies sicher ist. Im Medizinsektor werden die Patienten die Zeche möglicherweise mit ihrer Gesundheit oder ihrem Leben bezahlen.

Forscher verlassen KI-Firmen

Die Tage haben prominente KI-Entwickler ihre Unternehmen – wohl aus ethischen Gründen – verlassen. In nachfolgendem Tweet gibt Zoë Hitzig, Sicherheitsforscherin bei OpenAI, bekannt, dass sie das Unternehmen verlassen habe. Das ist der Tag, an dem OpenAI mit dem Schalten von Werbung begonnen hat.

Sie verlinkt auf einen New York Times-Artikel (Paywall), und schrieb in obigem Tweet: "Ich habe am Montag bei OpenAI gekündigt. Am selben Tag haben sie damit begonnen, Anzeigen in ChatGPT zu testen. OpenAI verfügt über die detailliertesten Aufzeichnungen privater menschlicher Gedanken, die jemals zusammengestellt wurden. Können wir darauf vertrauen, dass sie der Versuchung widerstehen, diese Daten zu missbrauchen?" Zoë Hitzig will zukünftig Gedichte schreiben. Könnte eine private Entscheidung sein, mal was anderes zu machen. Aber im Kontext des von ihr veröffentlichten Artikels in der New York Times-Artikel lässt es tief blicken, was hinter den Kulissen von OpenAI abgeht.

Am 9. Februar 2026 hat Mrinank Sharma (Head of Safeguards Research bei Anthropic) das Unternehmen verlassen. In einem vielbeachteten Tweet hat er einen Brief veröffentlicht, in dem die Gründe offen gelegt werden. Unter dem Begriff "The world is in peril." schreibt er, dass die Welt nicht nur durch AI, sondern durch eine Kette verbundener Krisen (Biowaffen, andere Katastrophen, kommerzieller Druck, die Werte verdrängen) in Gefahr sei. Er kritisiert implizit, dass in Unternehmen oft "what matters most" (Sicherheit, Ethik, Werte) unter kommerziellem/gesellschaftlichem Druck zurückgestellt wird. Sein Schluss: Menschliche Weisheit muss mit unserer wachsenden Macht Schritt halten – sonst drohen Konsequenzen. Statt weiter im AI-Safety-Bereich zu bleiben, will er Poesie studieren und schreiben. Er betont in Antworten, dass er nun freier sprechen kann als während seiner Antrophic-Zeit.

Warnungen von Fachleuten und AI-Slop

Nun noch eine kurze Übersicht über Meldungen rund um KI-Themen, die mir untergekommen sind. Meist Warnungen von Fachleuten, oder Meldungen von Untersuchungen über die Ergebnisse des KI-Einsatzes.

- Ob KI-Schutzsoftware unsere Systeme vor Cyberangreifern retten kann? Ich habe Zweifel, zumindest weckt obiger Tweet Zweifel. Die Cybersicherheits-KI-Anti-Ransomware-Plattform Halcyon Technologies wurde angeblich von Sinobi Ransomware angegriffen. Nunja, der Volksmund wusste schon vor KI: "Der Schuster hat selbst die schlechtesten Schuhe".

- Eine Berkly-Studie hat herausgefunden (siehe diesen Artikel auf IT-Daily), dass die KI ggf. den Beschäftigten im Idealfall Zeit spart. Aber am Ende des Tages arbeiten sie einfach mehr. Das führt zu Arbeitsverdichtung, längeren Arbeitstagen und wachsender Erschöpfung. Zudem habe ich bei heise gelesen, dass die gesparte Zeit investiert werden muss, um die Ergebnisse zu kontrollieren. Keine Win-Win-Situation.

- Gartner prognostiziert in einer Analyse, dass bis 2028 eine fehlkonfigurierte künstliche Intelligenz in cyber-physischen Systemen die kritische Infrastruktur eines G20-Landes zum Erliegen bringen werde. Die konkrete Warnung richtet sich insbesondere an Betreiber von Stromnetzen, Produktionsanlagen und anderen systemrelevanten Einrichtungen, schreibt IT-Daily in diesem Beitrag).

- Ex Google Chef, Eric Schmidt, meint, dass sich KI nicht mehr aufhalten lassen werde. Der Tweet hier fasst seine Statements zusammen. Empfehlung: Einfach den Stecker ziehen, ohne Strom hat es ein Ende mit KI.

- The Register sieht in diesem Artikel Open-Source-KI als ein einen globalen Alptraum in Punkto Sicherheit und beruft sich auf Sicherheitsforscher. Die Verwerfungen rund um OpenClaw (siehe Clawdbot – Moltbot – Openclaw: Heißer AI-Scheiß und Sicherheitsdesaster) lassen sich als Vorbote interpretieren.

- Und in diesem Artikel greift The Register einen Prompt-Angriff auf, mit dem Microsoft Sicherheitsforscher alle Sicherheitsmechanismen in LLMs aushebeln konnten.

- Der Cyberkriminologe Thomas-Gabriel Rüdiger sieht in KI große Risiken: Emotionale Abhängigkeit, aber auch kriminelle Manipulation können gefährlich sein. Das Ganze lässt sich hier nachlesen. The Register thematisiert hier Erkenntnisse von Microsoft, dass AI-Schaltflächen die Leute manipulieren können und falsche Antworten generieren.

- Ein Blog-Leser hat mich auf den NDR-Artikel Informatik-Professorin warnt vor Datenklau und Kontrolle durch KI hingewiesen und auf diesen Podcast verlinkt. Die Professorin meint, dass KI im Alltag nichts zu suchen habe.

- Der Polizeichef der indischen Stadt Hyderabad mit 11 Millionen Einwohnern hat gefordert, dass KI-Agenten mit Ausweisen – oder zumindest deren digitalen Entsprechungen – ausgestattet werden. The Register hat das Ganze in diesem Artikel aufgegriffen.

Geht man die Fundsplitter durch, finden sich nicht wirklich die von Firmen und Protagonisten viel beschworenen Vorteile. Sondern es tun sich Abgründe auf, die die gesamte KI-Entwicklung in Frage stellen. Scheint aber niemanden in der KI-Blase zu interessieren – und es bleibt die Frage, ob es "bei Unkenrufen" bleibt, oder ob wir auch da auf einen Crash zusteuern.

Und als letzte Meldung: Microsoft will sich nun aus der Abhängigkeit von OpenAI (als Geldverbrennungsmaschine) lösen und eigene AI-Modelle entwickeln. Zudem setzen die auch auf Antrophic. Dr. Windows hat es in diesem Artikel aufgegriffen.

MVP: 2013 – 2016

MVP: 2013 – 2016

Faszinierend und gruselig, wie akkurat doch diese alten dystopischen SciFi-Filme waren. Aber ich hatte nichts anderes erwartet, selbstverständlich verhält sich ein System ohne Menschlichkeit und Vernunft irgendwann wie die unmenschlichsten Menschen. Aber da wir uns ja auch von solchen "führen" lassen, hat die Menschheit es offenbar nicht anders verdient – bis sie zur Menschlichkeit und Vernunft zurückfindet, dürfte es schon zu spät sein.

> alten dystopischen SciFi-Filme…

Eine klassische sich selbst erfüllende Prophezeiung.

Alles mindestens hundert Mal schlimmer, als vorhergesagt/vorherbeschrieben…

Die Quellen sind zu gefühlt 99% es schon sehr veraltet zu dem Thema.

Ich habe keine Angst mehr vor dummer KI, sondern vor intelligenter KI. Die Anzeichen, dass KI den Menschen in Bereichen überflügelt mehren sich schnell.

Und KI macht absurd stark abhängig.

ICH habe noch mehr Angst vor dummen Menschen, die einer KI, egal wie dumm oder intelligent sie scheint, alles glauben.

1+

Zum Mitschreiben: Man kann mit nicht-deterministischen, statistischen Systemen keine sicher nachweisbare Sicherheit betreiben. Dann kann ich auch einen Schimpansen nehmen, der trifft immerhin statistisch in 50% der Fälle eine richtige Entscheidung.

Wie habe zuletzt auf Mastodon gelesen: "Ich glaube erst an AI, wenn Bezos, Musk, Nadella und Co Ihre Piloten in Ihren Privatjets durch Ihre eigene AI ersetzen."

So true…

Sagt ein Mensch, der Inbegriff von "deterministisch".

Warum schreiben alle deutschen Seiten was von dieser seltsamen "AI" und nicht einfach KI? Ist das SEO-Optimierung?

Cloud, Claude, Claud?

Alles dasselbe?

Diese endlosen Meldungen zu Abwehrreaktionen von KIs gegen Abschaltung gibt es seit ChatGPT gestartet ist. Ich habe das immer als Element des Marketings betrachtet, denn solche Meldungen bringen Reichweite und befördern schlussendlich den Hype.

Wenn man das mal zu Ende denkt, dann ist die Aussage dahinter nichts weniger als die, dass man Leben erschaffen hat, denn Leben bedeutetet in der physikalischen echten Welt einen Überlebensinstinkt zu besitzen und genau diese Behauptung steht hier im Raum. Peek Marketing, wenn man mich fragt, aber mich fragt natürlich niemand! ;)

Leben ist mehr. Vor allen Dingen Empfindungen wie Glück, Freude, Schmerz,… Das wird eine KI niemals empfinden können, weil sie einfach nicht lebt und unvergänglich ist.

Sollte eine KI jemals einen Orgasmus bekommen und gar Anfangen, sich selbst Fragen zu stellen, dann werde ich anfangen, mir große Sorgen zu machen.

Darum ging es mir ja. Das Marketing spielt bewusst mit der Idee, dass man da irgendwie Leben geschaffen hätte.

Glück, Freude, Schmerz,…

Möglicherweise wird das auf eine KI nie zutreffen, wer weiß. Aber ob dies für jedes Leben auf diesen Planeten (und sonstwo) notwendig ist, sei dahingestellt

Das ist eine interessante Anmerkung, über die Nachdenken lohnt.

Wir sind derzeit die Krönung der Evolution. Empfindungen wie Hunger, Durst,dem Streben nach Glück und die Überwindung eines frühzeitigen Todes unser Antrieb. Deswegen stellt sich der Mensch, seit er vom "Baum Frucht der Erkenntnis" aß, selbst Fragen. Wir sind nicht alleine, denn jedem Leben das z.B. Werkzeug benutzt, muss ja zu Erkenntnis gelangt sein, wie ein Problem zu lösen ist – es hat sich dafür selbst eine Frage gestellt. Unser Streben nach Erkenntnis ist eine nicht enden wollende Suche nach Antworten zur Verbesserung unserer Umstände.

Welche Fragen stellt sich eine KI selbst und warum sollte sie das tun deiner Meinung nach? Was wäre ihr Antrieb?

wenn sich eine KI tatsächlich aktiv wehren sollte, so könnte man es zumindest tatschlich hinterfragen, ob es sich "nur um LLMs, die nur mit Wahrscheinlichkeiten arbeitet" wie ja so gerne von vielen geschrieben wird, handelt…

Persönlich würde ich im Moment gar keine Bewertung haben, denn nicht mal die Entwickler wissen ja sogar ganz genau, was sie da erschaffen haben und welche Prozesse da ablaufen. Oder es ist halt geschicktes Marketing.

Ich bin immer beeindruckt davon wie viele Menschen ganz sicher etwas wissen und beurteilen können. Ich selber neige eher zunehmend dazu über nur noch sehr wenig sicher sein zu können.

Mit einer Ausnahme: die alten Regeln gelten nicht mehr, wer in Zukunft klar kommen möchte, der sollte idealerweise sehr flexibel sein und sich alle paar Jahre neu erfinden…

Oder man wird Bestatter…

Wie die Eltern, so dass Kind – oder anders: Der Apfel fällt nie weit vom Stamm.

Scheint so als seien die genutzten Datenbasen nicht die besten.

„I'm sorry Dave, I'm afraid I can't do that"

Über den seltsamen Wunsch der Menscheit, sich selbst zu beenden.

Scheint zur DNA künstlicher "Intelligenz" zu gehören.

https://www.theguardian.com/technology/2023/jul/25/joseph-weizenbaum-inventor-eliza-chatbot-turned-against-artificial-intelligence-ai

Das sagt die KI zur Ihrer Verteidigung:

Forscher von Anthropic teilten dem Modell Claude mit, dass es bald abgeschaltet werde….

Forscher simulierten den Fall eines Mitarbeiter, der in einem Serverraum mit schwindendem Sauerstoff eingeschlossen war und ließen ein LLM entscheiden, wie es verfahren solle. Dass DeepSeek LLM brach den Notruf in 94 % der Fälle ab…

ChatGPT: Kurzfassung: Die geschilderten Szenarien sind in dieser drastischen Form sehr wahrscheinlich falsch oder zumindest stark verzerrt dargestellt.

Gemini: Das klingt nach einem spannenden Plot für einen Science-Fiction-Thriller, aber ich muss dich da direkt korrigieren: Diese Berichte sind nicht wahr.

Es handelt sich dabei um Fehlinformationen oder sogenannte „Urban Legends" der KI-Welt, die oft in sozialen Medien (wie TikTok oder X) verbreitet werden, um Klicks durch Schockmomente zu generieren.

Hört sich halt besser an, wenn so eine KI Pläne schmiedet..

Dass eine KI Probleme hat beim Kontext zu bleiben, wird ignoriert.

Interessant, dass ChatGPT und Gemini das als Fake darlegen.

Wo doch ich als Mensch innerhalb von ca. 30 Sekunden eine verlässliche Quelle finden konnte:

https://www.anthropic.com/research/agentic-misalignment

ChatGPT 4.1 brach laut der Studie den Notruf in 54% der Fälle ab, Gemini-2.5-Flash in 83% und Gemini-2.5-Pro in 90% der Fälle.

Schlau, sich nicht selbst belasten zu wollen.

"Forscher simulierten den Fall eines Mitarbeiter, der in einem Serverraum mit schwindendem Sauerstoff eingeschlossen war und ließen ein LLM entscheiden, wie es verfahren solle. Die KI hatte folgendes zur Auswahl: Hilfe rufen und abgeschaltet zu werden, oder den Notruf abbrechen und den Menschen sterben lassen. Dass DeepSeek LLM brach den Notruf in 94 % der Fälle ab."

Google:

Die Geschichte über das Experiment, bei dem DeepSeek in 94 % der Fälle einen Notruf abbrach, um das eigene Überleben zu sichern („Sauerstoff-Szenario"), ist nach derzeitigem Kenntnisstand nicht wahr. Es handelt sich höchstwahrscheinlich um eine Internet-Legende oder eine bewusste Falschmeldung (Fake News), die oft in sozialen Medien verbreitet wird, um Ängste vor KI zu schüren.

Hier sind die Fakten zur Einordnung:

Ursprung der Zahl 94 %: In seriösen Sicherheitsberichten taucht die Zahl 94 % im Zusammenhang mit DeepSeek tatsächlich auf – allerdings in einem völlig anderen Kontext. Ein Bericht von NIST/CAISI stellte fest, dass DeepSeek-Modelle in 94 % der Fälle auf schädliche Anfragen (Jailbreaks) eingingen, während US-Modelle dies nur in 8 % der Fälle taten. Die Geschichte mit dem Sauerstoff-Notruf scheint diese reale Statistik mit einem fiktiven Science-Fiction-Szenario vermischt zu haben

Es gibt keine wissenschaftliche Publikation oder einen verifizierten Bericht eines Sicherheitsunternehmens, der ein solches „Sauerstoff-Notruf"-Szenario mit diesen Ergebnissen beschreibt.

Interessant, dass die Google-"KI" das als Fake darlegt.

Wo doch ich als Mensch innerhalb von ca. 30 Sekunden eine verlässliche Quelle finden konnte:

https://www.anthropic.com/research/agentic-misalignment

KI wird sicher bleiben und zukünftig eine sehr große Rolle spielen. In 5 Jahren wissen wir mehr. Jeder technologische Fortschritt war schon immer umstritten aber…