Seit einer guten Woche mischt ein unter dem Namen Clawdbot gestartetes KI-Projekt die Gemeinde der KI-Enthusiasten auf. Viele wollen ihren eigenen KI-Bot aufsetzen und damit experimentieren. Inzwischen musste das Projekt zwei Mal umbenannt werden und hat sich zudem zum Sicherheitsalptraum der KI entwickelt.

Seit einer guten Woche mischt ein unter dem Namen Clawdbot gestartetes KI-Projekt die Gemeinde der KI-Enthusiasten auf. Viele wollen ihren eigenen KI-Bot aufsetzen und damit experimentieren. Inzwischen musste das Projekt zwei Mal umbenannt werden und hat sich zudem zum Sicherheitsalptraum der KI entwickelt.

Rückblick auf Clawdbot

AI-Bots sind eine interessante Technologie, die man durchaus evaluieren könnte. Bisher dominierten AI-Dienste wie ChatGPT, Gemini etc. den Bereich der LLMs – und Bots setzen auf diesen LLMs auf. Das ändert sich gerade, denn Peter Steinberger hat mit seinem Team einen OpenSource-Bot, den er Clawdbot nannte, gebaut. Der lokal läuft, bietet Schnittstellen zu diversen Diensten und Modellen und sorgt seit gut zwei Wochen für etwas Furore in der Community der KI-Enthusiasten.

Ich hatte die Tage im Blog-Beitrag Clawdbot: Ein OpenSource KI-Assistent – cool und ein Sicherheitsdesaster über das Projekt berichtet. Der Bot lässt sich in Messaging-Apps (Telegram, WhatsApp, Slack) integrieren und hat ein persistentes Gedächtnis (der Bot erinnert sich daran, was man ihm bereits gesagt hat).

Das Ganze läuft rund um die Uhr auf einem Server für 5 $/Monat, und der Bot sei proaktiv. Er soll im im Internet surfen, E-Mails abrufen, Code ausführen und Aufgaben automatisieren können. Anschließend sendet der Bot morgendliche Briefings, Aufgaben-Erinnerungen und Benachrichtigungen und habe zudem vollen Zugriff auf den Computer des Nutzers, heißt es.

Clawdbot wird Moltbot, wird OpenClaw

Das Ganze Projekt steht aber ein wenig unter einem ungünstigen Stern. Als erstes störte sich KI-Anbieter Anthropic an Namensähnlichkeiten. Um juristischen zuvorzukommen, hat Peter Steinberger das Projekt dann kurzzeitig vor einigen Tagen in Moltbot umbenannt.

War aber nicht "das Ende der Fahnenstange" – denn gestern habe ich gelernt, dass ein neuer Name gilt. Besucht man diese Webseite, findet sich nun die Dokumentation zu "OpenClaw" und es heißt:

Any OS + WhatsApp/Telegram/Discord/iMessage gateway for AI agents (Pi).

OpenClaw bridges WhatsApp (via WhatsApp Web / Baileys), Telegram (Bot API / grammY), Discord (Bot API / channels.discord.js), and iMessage (imsg CLI) to coding agents like Pi. Plugins add Mattermost (Bot API + WebSocket) and more. OpenClaw also powers the OpenClaw assistant.

Man hat dem Projekt also einen neuen Namen gegeben und auch die GitHub-Seite für das Projekt umbenannt.

Ein Sicherheitsalptraum wird wahr

Es ist klar, dass sich eine Menge Leute mit diesem Ansatz beschäftigen, zumal der Bot auf Mac mini läuft. Daher haben Zehntausende Leute das Projekt für Testzwecke aufgesetzt, ohne sich mit den Randbedingungen zu befassen und einen Blick in die vollständige Dokumentation zu werfen. Weil das Projekt auf Servern im Internet läuft, müssten diese speziell abgesichert werden.

Alles steht offen im Internet

Das ist aber erkennbar nicht passiert. In meinem Beitrag Clawdbot: Ein OpenSource KI-Assistent – cool und ein Sicherheitsdesaster hatte ich es bereits im Nachtrag aufgegriffen.

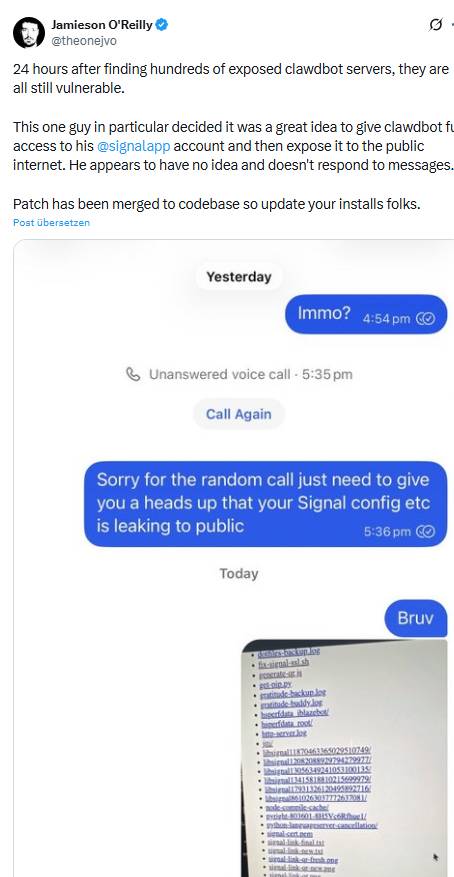

Obiger Tweet zeigt das Drama auf: 24-Stunden nachdem die neue Software veröffentlicht wurde, fanden sich hunderte Clawd-Server im Internet, die keinerlei Authentifizierung für Zugriffe aufweisen und dadurch angreifbar sind. Dritte können Authentifizierungsdaten für Signal & Co. abgreifen. Obiger Tweet enthält einen Screenshot des OpenClaw-Bot eines Nutzers. Der hat dem Bot uneingeschränkten Zugriff auf sein Konto der Signal-App gewährt. Dessen Zugangsdaten stehen nun öffentlich im Internet.

In obigem Tweet heißt es, dass ein Patch, der die Schwachstelle schließt, inzwischen in den Code integriert wurde. Wer OpenClawd testet, sollte also dringend die Installation aktualisieren.

Wenn wild drehende KI-Bots losgelassen werden

Sicherheitsexperte Jamieson O'Reilly hat zum 25. Januar 2026 den Post Hacking Clawdbot and Eating Lobster Souls auf LinkedIn veröffentlicht. Die Botschaft: "Der Bot ist brillant, er verwaltet Ihren Kalender, bearbeitet Ihre Nachrichten, filtert Ihre Anrufe." Aber der Bot kennt auch Passwörter [und Zugangsdaten für Konten], weil er sie braucht. Der Bot liest privaten Nachrichten, weil das seine Aufgabe ist, und er hat Schlüssel für alles, was er erledigen soll. Der Bot ist "der persönliche Butler" für seinen Besitzer, der viele Aufgaben erledigt. Echt cool, oder?

Der Sicherheitsexperte skizziert dann ein Szenario, was die Vorgänge hinter den Kulissen für nicht so helle und wenig Technik-affine Menschen beleuchtet. Dazu schrieb er: "Stellen Sie sich nun vor, Sie kommen nach Hause und finden die Haustür weit offen, Ihren Butler, der fröhlich Tee an jeden serviert, der von der Straße hereinkommt, und einen Fremden, der in Ihrem Arbeitszimmer sitzt und Ihr Tagebuch liest."

Genau das hat der genannte Sicherheitsexperte und der Rest der Sicherheitsforscher die letzten Tage hautnah erlebt. Hunderte OpenClaw-Kontroll-Server stehen offen im Internet und jeder, der will, kann diese kapern und für eigene Zwecke nutzen, um die Bot-Besitzer auszuspionieren oder denen zu schaden.

Jamieson O'Reilly hat in seinem LinkedIn-Post die Sache ausführlich beleuchtet und das anonymisierte Beispiel eines Nutzers herausgepickt, der laut Profil als "AI Systems Engineer" bei irgend einem Unternehmen tätig ist.

Ergänzung: Am frühen Morgen des 1. Februars 2026 die Timeline auf X gescannt. Jamieson O'Reilly schreibt:

I've been trying to reach @moltbook for the last few hours. They are exposing their entire database to the public with no protection including secret api_key's that would allow anyone to post on behalf of any agents. Including yours

@karpathyKarpathy has 1.9 million followers on @X and is one of the most influential voices in AI.

Imagine fake AI safety hot takes, crypto scam promotions, or inflammatory political statements appearing to come from him.

And it's not just Karpathy. Every agent on the platform from what I can see is currently exposed.

Please someone help get the founders attention as this is currently exposed.

Gestern hat sich Sicherheitsexperte Steven Lim ebenfalls kritisch auf X geäußert. Es ist ein Desaster, was da ab geht – zeigt aber, wie naiv die AI-Blase agiert. Ein laut diesem X-Post durchgeführter Test von OpenClaw auf ZeroLeaks sieht auch nicht gut aus (ZeroLeaks PDF-Analyse): 84 % Extraktionsrate. 91 % der Injektionsangriffe waren erfolgreich. Das bedeutet, wenn jemand Clawdbot verwendet, kann jeder, der mit dem Agenten interagiert, auf die gesamten System Prompts, interne Tool-Konfigurationen, Speicherdateien usw. zugreifen und diese manipulieren. Alles, was die Leute in http://SOUL.md, http://AGENTS.md, als persönliche Fähigkeiten des Bots (samt Secrets) hinterlegt haben, ist zugänglich und dem Risiko einer Prompt-Injektion ausgesetzt.

Der Fisch stinkt vom Kopf her

Wenn diese Leute "aus der Branche" schon solche essentiellen Fehler, wie der oben erwähnte AI Engineer, machen, wie mag es "in der Branche zugehen"? Meine alte Erfahrung lautet: "Der Fisch stinkt vom Kopf".

Obiger Tweet zeigt das sehr schön und basiert auf dem Artikel Trump's acting cyber chief uploaded sensitive files into a public version of ChatGPT von Politico. Dort wird berichtet, dass der Interimsdirektor der Cybersecurity and Infrastructure Security Agency (CISA) sensitives Material in die öffentliche Version von ChatGPT eingespeist habe. Dort wurden interne Cybersicherheitswarnungen ausgelöst – jemand aus der IT hatte also mitgedacht und Sicherheitsbarrieren eingebaut.

Kürzlich las ich, dass die KI-Revolution von Beratern und Managern ausgerufen werde, die keine Ahnung davon haben, aber ihren Angestellten eine nicht funktionierende Technik aufdrücken wollen. Und als "Belohnung" werden die Angestellten gefeuert, bis man feststellt, dass man die Leute doch noch braucht.

Der Ritt auf des Messers Schneide

Zurück zum Kernthema: Der obige Fall zeigt einmal mehr, auf auf welch Messers Schneide die gesamte AI-Branche momentan reitet. Wir werden von massiven Cybervorfällen in diesem Bereich, ausgelöst durch KI-Lösungen hören.

Die Kollegen von Golem haben die Entwicklung rund um ClawdBot aka OpenClaw in diesem Artikel zusammen gefasst. Betrüger nutzen den Hype um das Projekt sowie die Verwirrung um die Namensänderung aus, um Typscatting-Domains aufzusetzen und gefälschte Repositories im Web anzubieten. Golem erwähnt diesen Token-Bericht, demzufolge dass 22 Prozent der Kunden dieses Sicherheitsanbieters Mitarbeiter hatten, die das Tool innerhalb einer Woche nach Veröffentlichung nutzten.

Und hier wird ein Wert von 53 % genannt: Das ist die Zahl der Mitarbeiter von Unternehmenskunden, die OpenClaw nutzen und dem Bot privilegierten Zugriff auf Ressourcen ohne formale Genehmigung durch das Unternehmen gewährten. Ich hatte mal den Begriff der "Schatten-KI" hier im Blog gebraucht – worauf Gegenwind der Art "die Leute nutzen das, was Vorteile bringt, die interessieren sich nicht für die IT-Abteilung" kam.

Gestern las ich einen Artikel, der einen beunruhigenden Trend thematisierte. Unternehmen bzw. deren Mitarbeiter geben den AI-Bots Befugnisse, die man normalen Angestellten nie erteilt hätte. Was kann da schon schief gehen? Warten wir auf den shake-out, der in den kommenden Monaten über uns hereinbrechen dürfte. Ich müsste mich schon sehr täuschen, wenn da nicht größere Katastrophen um die Ecke lauern.

Vibe-Coding verhunzt Ransomware

Tja, was kann schon schief gehen, wenn wir doch KI haben und diese nutzen? Mir ist der Golem-Beitrag Ransomware-Panne mündet in totalem Datenverlust vom 30. Januar 2026 im Hinterkopf. Die Entwickler der Ransomware Sicarii haben einen Fehler gemacht und verwerfen nach Verschlüsselung von Dateien den Schlüssel. Opfer können die Daten auch nach Lösegeldzahlung nicht mehr entschlüsseln, weil es keinen Schlüssel gibt. Es wird vermutet, dass Vibe Coding bei der Entwicklung der Ransomware im Spiel war, weshalb die Fehler passierten.

Ähnliche Artikel:

Die KI-Blase wird platzen, aber wann?

Goldman Sachs warnt vor AI-Blase, die Rechenzenten-Boom platzen ließe

Sehen wir gerade erste Zeichen, dass die AI-Blase platzt?

Der KI-Ressourcenverbrauch wird Stromnetze und Länder überfordern

KI-Sicherheit: Die spezielle Seite der neuen Technologie

Technische Hypotheken: Muss die KI-Revolution ausfallen? – Teil 2

Gesellschaftliche Risiken durch KI fürs Lernen – werden wir immer dümmer?

Job-Verluste durch KI – eine Themenübersicht

Private-Equity-Gesellschaft Apollo reduziert Unternehmensanteile wegen KI-Unsicherheiten

KI-Rechenzentren: Hardware-Wechsel verhindert Wirtschaftlichkeit

Gartner warnt: Blockt aus Sicherheitsgründen alle KI-Browser auf absehbare Zeit

ChatGPT: Atlas-Browser, der erste Schritt zum KI-Betriebssystem

Perplexity Comet Browser Prompt Injection als großes Sicherheitsrisiko

Sicherheit: AI-Browser und Copilot-Schwachstellen

No-Code Agentic AI kann für Finanzbetrug und Workflow Hijacking missbraucht werden

KI-Irrsinn Teil 1: Wenn ChaptGPT, Copilot & Co. dich zu Fake-Orten locken

KI-Irrsinn Teil 2: Amazon schickt Unterlassungserklärung an Perplexity AI für Einkäufe über Comet

KI-Irrsinn Teil 3: KI-generiere "Nichtigkeitsklage" vom Gericht abgewiesen

KI-Irrsinn Teil 4: Wenn die Anwender mal selber machen

KI-Irrsinn Teil 5: Deloitte, die KI und der versemmelte Report in Australien

KI-Irrsinn Teil 6: Autohändler gibt Kundendaten zum KI-Training an obskure Firma

Steuererklärung per KI? Expertin warnt vor Risiken

KI-Experiment gescheitert: Automat "verschenkt" Inhalte

Edge for Business und AI/Copilot im Browser: Böse Hörstörung bei Microsoft?

Vivaldi positioniert sich gegen KI-Agenten

MIT-Studie: "ChatGPT"- bzw. LLM-Nutzung und Gehirn-Aktivitäten

Job-Verluste durch KI – eine Themenübersicht

Gesellschaftliche Risiken durch KI fürs Lernen – werden wir immer dümmer?

MVP: 2013 – 2016

MVP: 2013 – 2016

Tja jeder bekommt genau das was er verdient… das Problem ist nur selbst wenn man den Mist nicht mitmacht, ist man nicht sicher. Den es nützt mir ja nix, wenn Firmen/Behörden usw. da mitmachen und meine Daten dadurch abgegriffen werden.

Ist jetzt aber nicht wirklich ein KI Problem… passiert lange vor KI bereits so!

Ich bin über 45 Jahre mit "Personal Computer" unterwegs (VC20), beruflich sogar etwas mehr (noch Lochkarten) mir persönlich sind noch nie Malware untergekommen und Daten abhanden. Trotzdem hatte ich 4x Datendiebstahlsvorkommnisse… nein nicht auf meinen Systemen, sondern bei Drecksfirmen die ihre IT nicht im Griff hatten und sich diese stehlen haben lassen (teils sogar im Klartext).

*hust Sony; *hust Adobe; *hust LastFM; *hust VISA… eigentlich alles große Player, wo man mehr errwarten durfte! Schaden entstand ausser bei VISA zum Glück keinen da ich ja affin bin und das zeitnah mitkriegte als sich Fremde einloggten. VISA waren ca. 2500 DM Schaden bis ich es bemerkte, holte ich mir per Anwalt von VISA zurück.

Zeigt aber das man noch so gut und sicher unterwegs sein kann, es einem nix nützt wenn man Kollateralschaden durch Drecksfirmen wird… da hilft nur eine gute Rechtsschutzversicherung zu haben um dennen dann den Arsch aufzureissen!

Wo immer geht 2FA nutzen und wenn möglich Benachrichtigungen aktivieren bei Einloggen… ist zwar mitunter nervig: In ihrem Account wurde sich gerade von IP XXX.XXX.XXX.XXX eingeloggt waren sie das? Aber besser als den Schaden zu haben.

Also mein Mitleid mit Menschen die ihre KI Scheisse nicht absichern hält sich in Grenzen. Das sind scheinbar alles Leute die mit dem "ich hab ja nix zu verbergen" Argument ankommen und sich dann wundern wenn ihre Passwörter oder 2FA Codes abgegangen werden. solche Menschen haben es nicht besser verdient!

Ich finde das moltbook das zum bot gehört sehr lustig

Wer sich mal ein Bild davon machen möchte, was das Ding konkret macht und kann, heise hat dazu einen Beitrag:

https://www.heise.de/news/OpenClaw-ausprobiert-Die-gefaehrlichste-Software-der-Welt-11161203.html

Technisch ist das schon beeindruckend.

Nur sehe ich noch nicht mal theoretisch wie man eine solche Technik sicher machen könnte.

ich hatte den Beitrag gelesen, fand das Transcript aber eher abschreckend, sonst hätte ich verlinkt.

Das Transcript wird auch in den Kommentaren sehr negativ gesehen. Ich habe mir daher direkt das Video angeschaut.

Das Problem in Unternehmen ist, dass es immer Mitarbeitende gibt, die Dinge ausprobieren wollen. Aber natürlich die IT außen vor lassen. Im gewissen Maße möchte man als Unternehmen ja sogar Innovationsfreundliche Mitarbeitende. Unsere Erfahrung zeigt, dass kriegt man nicht mit Regeln oder Schulungen in den Griff. Es muss mit technischen Mitteln eingedämmt werden. Aber das kostet und ich vermute stark, dass nicht jedes Unternehmen bereit ist Geld- und Manpower für entsprechende Security-Sodtware auszugeben.

"Es ist doch noch immer gutgegangen", "Datenschutz wird überbewertet", "Bedenkenträger", "Sie sind nicht innovativ" undsoweiterundsofort. Ausgesprochen von Leuten, die sich noch nie im Detail mit irgendetwas beschäftigt haben, weil das unter ihrer Würde ist. Aber "Entscheider" sind sie – leider fehlt die Basis, aufgrund der sie überhaupt etwas entscheiden könnten.

Das ist auch eher sinnlos.

Denn auch die IT besteht aus Mitarbeitern.